Informations archivées

L’information dont il est indiqué qu’elle est archivée est fournie à des fins de référence, de recherche ou de tenue de documents. Elle n’est pas assujettie aux normes Web du gouvernement du Canada et elle n’a pas été modifiée ou mise à jour depuis son archivage. Pour obtenir cette information dans un autre format, veuillez communiquer avec nous.

Examen de l’efficacité de l’aide au développement de l’Organisation mondiale de la santé

2007-2010

Rapport final - décembre 2012

Table des matières

- Remerciements

- Abréviations, acronymes et symboles

- Résumé

- 1.0 Introduction

- 2.0 Méthode

- 3.0 Constatations relatives à l’efficacité de l’aide au développement de l’OMS

- 3.1 Les programmes de l’OMS semblent cadrer avec les besoins des intervenants et les priorités nationales

- 3.2 L’OMS semble avoir atteint ses objectifs de développement et les résultats escomptés

- 3.3 Les avantages des programmes de l’OMS semblent être durables, mais le maintien des capacités de ses partenaires suppose des difficultés

- 3.4 Les évaluations de l’OMS n’ont pas traité de l’efficience

- 3.5 Les évaluations de l’OMS n’ont pas traité de l’égalité entre les sexes et de la viabilité de l’environnement

- 3.6 Les évaluations font état de lacunes dans les systèmes de suivi et d’évaluation

- 4.0 L’OMS et les priorités du Canada en matière de développement international

- 5.0 Conclusions

- 6.0 Recommandations faites à l’ACDI

- Annexe 1 : Critères utilisés pour évaluer l’efficacité de l’aide au développement

- Annexe 2 : Échantillon d’évaluations

- Annexe 3 : Approche et méthodologie

- Annexe 4 : Qualité des évaluations – Grille de notation et résultats

- Annexe 5 : Guide à l’intention de l’équipe d’examen pour la classification des constatations des évaluations

- Annexe 6 : Documents internes examinés

- Annexe 7 : Financement de l’ACDI accordé aux organisations multilatérales d’aide humanitaire et de développement

- Annexe 8 : Réponse de la direction

Remerciements

La Direction de l’évaluation de l’ACDI tient à remercier toutes les personnes qui ont contribué à l’examen pour leur apport précieux, leur soutien constant et généreux, et leur patience.

Nous remercions d’abord l’équipe indépendante de la firme Goss Gilroy Inc., soit le chef d’équipe Ted Freeman et les analystes Danielle Hoegy et Tasha Truant. Nous voulons aussi remercier le ministère du Développement international du Royaume-Uni et l’Agence suédoise d’évaluation de la coopération pour le développement, qui ont apporté un appui sous forme d’analyses pendant les examens de l’Organisation mondiale de la santé (OMS) et de la Banque asiatique de développement.

La Direction de l’évaluation veut également remercier l’équipe de direction de la Direction des initiatives mondiales de l’ACDI (Direction générale des programmes multilatéraux et mondiaux), à l’administration centrale à Gatineau, pour son précieux soutien.

Nos remerciements vont aussi aux représentants de l’OMS pour l’aide et les conseils pratiques et utiles qu’ils ont fournis aux évaluateurs.

À la Direction de l’évaluation de l’ACDI, nous remercions Vivek Prakash, agent d’évaluation, de son aide pour l’examen, de même que Michelle Guertin, gestionnaire de l’évaluation de l’ACDI, d’avoir dirigé cet examen jusqu’à son achèvement et de sa contribution à la réalisation de ce rapport.

Caroline Leclerc

Directrice générale

Direction de la planification stratégique, du rendement et de l’évaluation

Liste des abréviations

- ACDI

- Agence canadienne de développement international

- BSCI

- Bureau des services de contrôle interne

- DAC-EVALNET

- Réseau du Comité d’aide au développement sur l’évaluation du développement

- GAR

- Gestion axée sur les résultats

- MOPAN

- Réseau d’évaluation du rendement des organisations multilatérales

- OCDE

- Organisation de coopération et de développement économiques

- OMD

- Objectifs du Millénaire pour le développement

- OMS

- Organisation mondiale de la santé

- ONG

- Organisation non gouvernementale

- ONU

- Organisation des Nations Unies

- PEV

- Programme élargi de vaccination

Résumé

Contexte

Le présent rapport expose les résultats d’un examen de l’efficacité de l’aide au développement de l’Organisation mondiale de la santé (OMS). Fondée en 1948, l’OMS est l’autorité chargée de la direction et de la coordination en matière de santé internationale au sein du système des Nations Unies, dans le but général d’atteindre le plus haut niveau de santé possible pour tous. Elle ne fournit pas directement de services de santé, mais coordonne plutôt les efforts de santé mondiaux et établit des normes mondiales en matière de santé. L’OMS emploie plus de 8 000 spécialistes de la santé publique, notamment des médecins, des épidémiologistes, des chercheurs, des gestionnaires, des administrateurs et d’autres professionnels. Ces spécialistes de la santé travaillent dans 147 bureaux de pays, six bureaux régionaux et à l’administration centrale à Genève.

Bien que la réduction de la pauvreté ne soit pas au cœur du mandat de l’OMS, l’organisation y contribue au moyen de son leadership mondial – par exemple, en établissant des normes mondiales de santé auxquelles se conforment les pays en développement et en appuyant la coordination de l’aide humanitaire – et de son assistance technique aux pays en développement.

Santé Canada assume la responsabilité première au regard de la coopération du gouvernement Canada avec l’OMS et dirige la délégation canadienne à l’Assemblée mondiale de la santé. Font partie des principaux engagements de l’Agence canadienne de développement international (ACDI) avec l’OMS le dialogue politique et les programmes d’aide au développement visant les maladies infectieuses, la santé des enfants et l’aide humanitaire. Plus précisément, l’OMS joue aussi un rôle essentiel dans l’élaboration d’indicateurs sur la santé et la collecte de données à l’appui de l’Initiative sur la santé des mères, des nouveau-nés et des enfants lancée par le Canada lors du Sommet du G8.

Grâce à l’appui financier de 284 millions de dollars canadiens fourni par l’ACDI pendant quatre exercices, soit de 2007-2008 à 2010-2011, l’OMS s’est classée au huitième rang des organisations multilatérales soutenues par l’ACDI en raison de la somme reçue. Dans le secteur de la santé, seul le Fonds mondial de lutte contre le sida, la tuberculose et le paludisme se classe à un rang plus élevé en raison d’une contribution de 450 millions de dollars canadiens de l’ACDI au cours de la même période.

But

L’examen vise à fournir une évaluation indépendante et fondée sur des données probantes de l’efficacité de l’aide au développement (ci-après appelée « l’efficacité ») de l’OMS pour répondre aux exigences d’évaluation établies par la Politique sur l’évaluation du gouvernement du Canada et pour fournir à la Direction générale des programmes multilatéraux et mondiaux de l’ACDI des données probantes sur l’efficacité de l’aide au développement de l’OMS.

Approche et méthode

L’approche et la méthode utilisées dans cet examen ont été établies sous la direction du Réseau du Comité d’aide au développement sur l’évaluation du développement (DAC-EVALNET) de l’Organisation de coopération et de développement économiques (OCDE). Deux essais pilotes sur l’OMS et la Banque asiatique de développement ont été menés en 2010, pendant la phase d’élaboration de l’approche et de la méthode communes. Le rapport repose donc sur l’analyse de l’essai pilote des rapports d’évaluation publiés par le Bureau des services de contrôle interne de l’OMS, ainsi que sur un examen des documents organisationnels de l’OMS et de l’ACDI et une consultation avec le gestionnaire de l’ACDI chargé de gérer les relations avec l’OMS.

La méthode ne se fonde pas sur une définition particulière de l’efficacité (de l’aide au développement). Le groupe de gestion et le groupe de travail mis sur pied par le DAC-EVALNET dans le but de mettre au point la méthode ont déjà cherché à déterminer s’il fallait utiliser une définition explicite de l’efficacité de l’aide au développement. En l’absence d’une définition convenue d’un commun accord, la méthode met l’accent sur certaines des caractéristiques essentielles d’une programmation efficace pour les organisations multilatérales sur le plan du développement que voici :

- Pertinence des interventions : les activités et les extrants de programmation sont adaptés aux besoins du groupe cible et de ses membres.

- Atteinte des objectifs de développement et des résultats escomptés : la programmation contribue à l’atteinte des objectifs de développement et des résultats escomptés à l’échelle nationale et locale dans les pays en développement (y compris des incidences positives pour les membres du groupe cible).

- Viabilité des résultats et des bienfaits : les bienfaits pour les membres du groupe cible et les résultats en matière de développement obtenus sont durables.

- Efficacité : les programmes sont offerts de manière rentable et dans les délais.

- Thèmes transversaux (viabilité de l’environnement et égalité entre les sexes) : les programmes sont inclusifs, en ce sens qu’ils appuient l’égalité entre les sexes et sont viables pour l’environnement (ainsi, ils ne compromettent pas les perspectives de développement futur).

- Amélioration de l’efficacité à l’aide de l’évaluation et du suivi : les programmes contribuent efficacement au développement en permettant aux organisations participantes qui offrent leur appui de tirer parti des expériences antérieures et d’utiliser des outils de gestion du rendement et de responsabilisation, tels que l’évaluation et le suivi, pour améliorer l’efficacité au fil du temps.

À partir de ces caractéristiques, un ensemble commun de critères d’évaluation s’inspirant des critères d’évaluation actuels du Comité d’aide au développement [CAD] (Annexe 1) a été établi pour la méthode d’examen. En juin 2011, l’approche et la méthode généralesNote de bas de page 1 ont reçu l’aval des membres du DAC-EVALNET; en effet, ceux-ci ont jugé qu’elles constituaient un outil acceptable pour évaluer l’efficacité de l’aide au développement des organisations multilatérales.

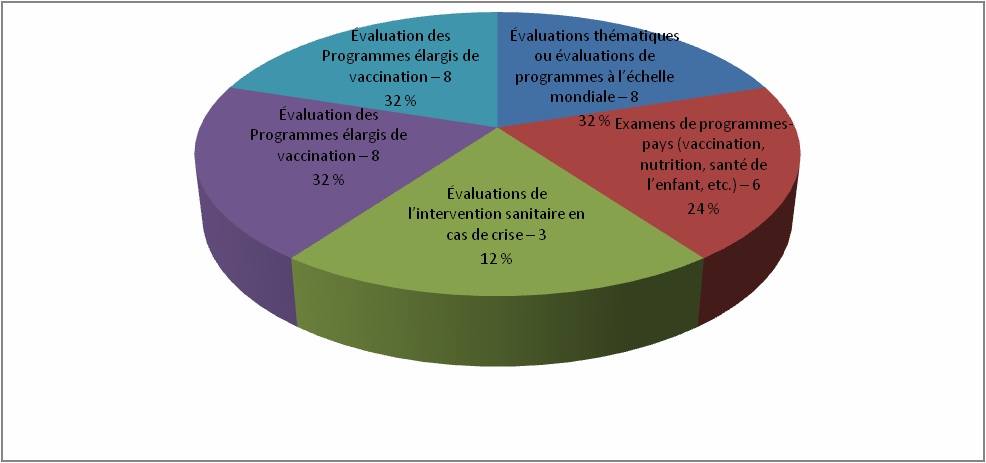

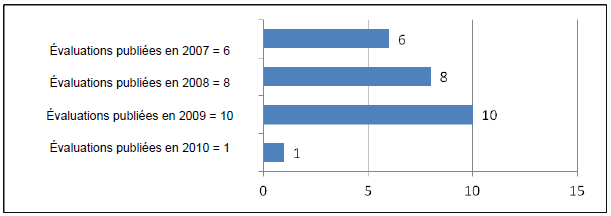

L’examen comportait une métasynthèse structurée d’un échantillon de 25 évaluations de l’OMS réalisées entre 2007 et 2010 à l’échelle nationale, régionale et mondiale ou thématique. Le processus d’échantillonnage est expliqué plus en détail à l’Annexe 3. Le nombre limité de rapports d’évaluation disponibles restreint ce rapport, comme nous le verrons plus loin.

Après avoir été étudiée pour en assurer la qualité (l’approche et les critères employés sont décrits à l’Annexe 4), chaque évaluation a été examinée dans le but de dégager les conclusions relatives aux six principaux critères (et aux sous-critères connexes décrits dans l’Annexe 1) qui seront employés pour évaluer l’efficacité. L’équipe d’examen a coté les constatations pour chaque critère à l’aide d’une échelle de 1 à 4 : « très satisfaisant », « satisfaisant », « insatisfaisant » ou « très insatisfaisant ». Cette notation reposait sur une grille d’instructions précises pour chaque note allouée aux sous-critères (Annexe 5). L’équipe d’examen a aussi déterminé les facteurs qui contribuent ou nuisent aux résultats.

Il est à noter que, bien qu’aucune évaluation n’ait été écartée en raison de lacunes attribuables à la qualité, les évaluations ne répondent pas à tous les critères déterminés dans les éléments essentiels à un développement efficace. C’est pourquoi cet examen se penche sur les données disponibles à propos de chaque critère avant de présenter des résultats, et qu’il ne comporte pas de résultats pour certains critères.

Les pourcentages indiqués dans le présent rapport sont fondés sur le nombre total d’évaluations traitant des sous-critères. Toutefois, la couverture des différents sous-critères dans les évaluations examinées varie; elle va d’une couverture élevée à une couverture faible. Des mises en garde sont fournies dans le rapport lorsque la couverture le justifie.

Outre les 25 évaluations, l’examen comportait une revue de documents stratégiques et de reddition de comptes pertinents de l’OMS, tels que les rapports du Comité du programme, du budget et de l’administration au Conseil exécutif, les rapports sur la réforme de l’OMS par le directeur général, les documents sur la politique d’évaluation, les rapports annuels et l’évaluation provisoire du plan stratégique à moyen terme (voir l’Annexe 6). Ces documents ont permis à l’équipe d’examen de juger de l’évolution continue de l’évaluation et de la reddition de comptes sur les résultats à l’OMS et de mettre en contexte les conclusions présentées dans les rapports d’évaluation.

L’équipe d’examen a aussi mené une entrevue auprès du personnel du Bureau des services de contrôle interne (BSCI) à l’OMS pour mieux comprendre l’univers des rapports d’évaluation disponibles de l’OMS et mettre en contexte la situation changeante de la fonction d’évaluation.

Enfin, l’équipe d’examen a mené une entrevue avec le gestionnaire de l’ACDI le plus directement responsable de la relation soutenue entre l’ACDI et l’OMS afin de mieux évaluer la contribution de l’OMS aux priorités de développement international du Canada.

Comme c’est toujours le cas avec les métasynthèses, des problèmes de nature méthodologique peuvent restreindre les constatations. Pour cet examen, la plus importante contrainte vise la généralisation des résultats de l’examen à tous les programmes de l’OMS. L’ensemble des rapports d’évaluation disponibles et valides ne fournit cependant pas une couverture suffisante des programmes et des activités de l’OMS pendant la période visée pour permettre une généralisation des résultats à l’ensemble des programmes de l’OMSNote de bas de page 2. Les rapports d’évaluation disponibles fournissent cependant des impressions sur l’efficacité de l’aide au développement des programmes de l’OMS évalués.

Principales constatations

Pas suffisamment de données probantes pour tirer des conclusions sur l’Organisation mondiale de la santé

Cet examen a principalement permis de constater que l’ensemble limité des rapports d’évaluation disponibles et valides ne contient pas assez de renseignements pour tirer des conclusions quant à l’efficacité de l’aide au développement de l’OMS.

Les rapports d’évaluation disponibles, bien que limités, fournissent des impressions sur l’efficacité de ces programmes de l’OMS. Les résultats de l’examen de ces évaluations sont présentés ci-dessous, mais en raison de la taille limitée de l’échantillon, ils ne peuvent être généralisés à l’organisation dans son ensemble.

Une analyse de la politique d’évaluation de 2012 de l’OMS indique que, bien que l’approbation d’une politique d’évaluation constitue un pas dans la bonne direction, des lacunes demeurent dans la politique pour ce qui est de la planification, de l’établissement de priorités, de la budgétisation et de la divulgation des évaluations de l’OMS. De plus, l’OMS pourrait éclaircir davantage les rôles et les responsabilités des gestionnaires de programme à l’égard des évaluations et fournir des conseils pour juger de la qualité des évaluations.

En 2012, un examen du Corps commun d’inspection des Nations Unies a aussi soulevé des inquiétudes à l’égard de l’indépendance et de la crédibilité des évaluations de l’OMS; selon cet examen, l’OMS devrait avoir une meilleure capacité d’évaluation centrale. On y recommande également qu’un examen par les pairs de la fonction d’évaluation soit mené par le Groupe des Nations Unies pour l’évaluation et présenté au Conseil exécutif de l’OMS d’ici 2014.

Dans l’échantillon limité qui était disponible, les programmes de l’OMS semblaient répondre aux besoins des intervenants et aux priorités nationales. Les évaluations indiquaient que les programmes de l’OMS étaient bien adaptés aux besoins des intervenants; 89 % des évaluations (soit 16 des 18 évaluations qui portaient sur ce critère) présentaient des constatations satisfaisantes ou très satisfaisantes, et étaient bien harmonisées aux objectifs de développement nationaux (les 12 évaluations qui portaient sur ce critère ont toutes été cotées satisfaisantes ou très satisfaisantes). De plus, les objectifs des projets et des programmes appuyés par l’OMS demeuraient valides au fil du temps (les 21 évaluations ont toutes été cotées satisfaisantes ou plus). Il y a cependant place à l’amélioration quant à la description de l’échelle des activités de programme de l’OMS par rapport à leurs objectifs (60 % des 20 évaluations étaient cotées satisfaisantes) et à des partenariats plus efficaces avec les gouvernements (61 % des 18 évaluations étaient cotées satisfaisantes ou très satisfaisantes).

Un facteur qui contribue à la pertinence des programmes de l’OMS est l’expérience de l’organisation à faire correspondre la conception des programmes au fardeau des maladies dans les pays partenaires. Une autre est la consultation d’intervenants clés à l’échelle nationale et locale pendant la conception des programmes.

L’OMS semble être plus efficace pour atteindre la plupart de ses objectifs de développement et ses résultats escomptés, puisque 71 % (15 évaluations sur 21 ont indiqué un rendement satisfaisant ou plus élevé). De plus, les programmes de l’OMS génèrent des avantages pour les membres du groupe cible à l’échelle individuelle, communautaire et du ménage, puisque 64 % des 14 évaluations montraient que le rendement pour ce sous-critère était satisfaisant ou très satisfaisant. Cependant, les évaluations n’indiquent pas uniformément le nombre de bénéficiaires qui ont pu profiter des interventions, et aucun résultat n’est signalé pour ce sous-critère. Dans l’atteinte des objectifs de l’OMS, les facteurs qui contribuent au rendement incluent une solide conception technique des interventions des programmes et de hauts niveaux de prise en charge nationale dans les principaux programmes.

Les avantages des programmes de l’OMS semblent être durables, mais le maintien des capacités de ses partenaires suppose des difficultés. Les avantages des programmes de l’OMS sont susceptibles d’être conservés, puisque 73 % des évaluations ont obtenu la cote « satisfaisant » ou « très satisfaisant » dans ce domaine (bien que seulement 11 évaluations abordent ce critère). Cependant, l’OMS est confrontée à un enjeu dans le domaine du renforcement de la capacité institutionnelle de ses partenaires en matière de viabilité. Seulement 37 % des évaluations (6 des 16 évaluations) ont conclu que les programmes de l’OMS étaient satisfaisants en termes d’appui à la capacité institutionnelle locale en matière de viabilité. Un facteur qui contribue à la viabilité a été le recours aux réseaux locaux de fournisseurs de services pour maintenir le succès des programmes de vaccination.

Efficience – Aucun résultat à signaler. À peine quelques évaluations ont fait état de la rentabilité (9 évaluations) et à savoir si la mise en œuvre des programmes et l’atteinte des objectifs se faisaient en temps voulu (5 évaluations). Les rapports d’évaluation qui portaient sur ces sous-critères faisaient état, le plus souvent, de facteurs qui nuisaient à l’efficience. Un élément commun de ces conclusions a été le lien entre les retards dans la mise en place des programmes et l’augmentation des coûts.

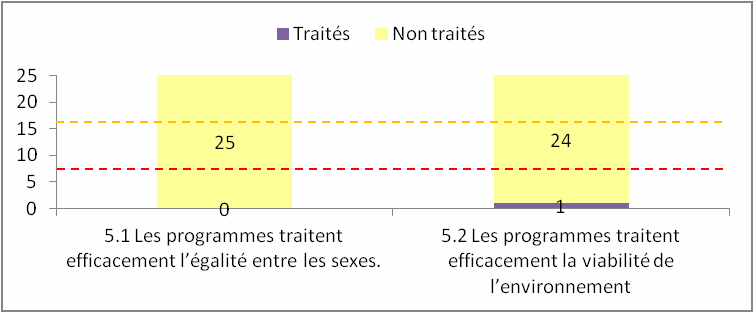

Évaluations de l’OMS qui ne portaient pas régulièrement sur l’efficacité dans l’appui à l’égalité entre les sexes ou à la viabilité de l’environnement. Aucune évaluation ne faisait état du thème transversal de l’égalité entre les sexes, et seulement une évaluation faisait état de la viabilité de l’environnement, ce qui n’a pas permis, au cours de l’examen, de déterminer si des résultats avaient été atteints dans ce domaine. L’absence de la question de l’égalité entre les sexes dans les évaluations de l’OMS constitue une lacune essentielle dans les renseignements sur l’efficacité de l’organisation.

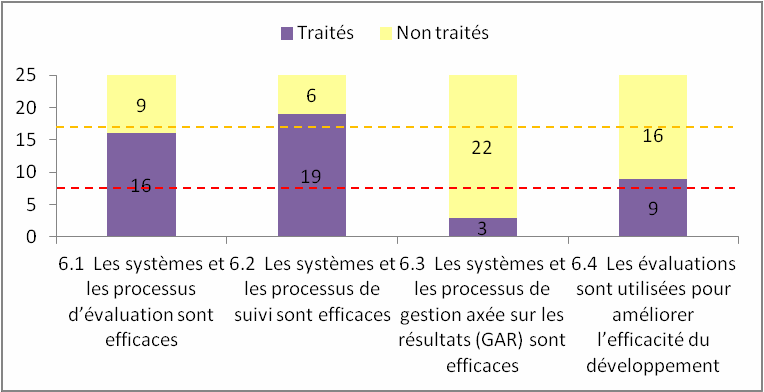

Les évaluations examinées ont permis de constater que les systèmes d’évaluation et de suivi de l’OMS sont insatisfaisants. En tout, 56 % des résultats déclarés sur l’efficacité des systèmes et des processus d’évaluation étaient cotés comme étant insatisfaisants ou très insatisfaisants (9 des 16 évaluations). Dans le même ordre d’idées, les systèmes de suivi sont insatisfaisants : 58 % des résultats des évaluations (11 des 19 évaluations) ont été cotés comme insatisfaisants ou très insatisfaisants. Les sous-critères relatifs aux systèmes et processus efficaces de gestion axée sur les résultats et les résultats d’évaluation employés pour améliorer l’efficacité de l’aide au développement ont été abordés dans seulement trois et neuf évaluations, respectivement. Aucun résultat n’est donc présenté pour ces sous-critères.

En particulier, les évaluations examinées signalent un manque de ressources financières et de personnel local qualifié; ce sont des facteurs importants qui contribuent à des résultats peu satisfaisants dans le domaine de l’évaluation et du suivi. Lorsque les systèmes d’évaluations sont déclarés satisfaisants, ce résultat est en partie attribuable à la tradition d’un examen conjoint de la mise en œuvre des programmes par l’OMS et ses partenaires.

Conclusions : l’efficacité de l’aide au développement de l’OMS

La fonction d’évaluation de l’OMS doit être renforcée : Tout compte fait, les rapports d’évaluation disponibles ne donnent pas assez de renseignements sur les programmes et les activités de l’OMS pendant cette période pour permettre de généraliser les résultats à l’ensemble de la programmation de l’OMS, mais ils fournissent des renseignements sur l’efficacité des programmes de développement de l’OMS qui ont été évalués.

Rendement : Les évaluations menées entre 2007 et 2010 indiquent que les activités de l’OMS sont très bien adaptées aux besoins des membres du groupe cible (16 de 18 évaluations) ainsi qu’aux objectifs et aux priorités des gouvernements nationaux (dans les 12 évaluations). De plus, les projets de l’OMS pendant la période examinée ont permis d’atteindre les objectifs de développement (15 de 21 évaluations) et de procurer des avantages positifs aux membres du groupe cible (9 de 14 évaluations). Les avantages directs de la programmation de l’OMS sont jugés durables dans la plupart des évaluations (8 des 11 évaluations) qui abordent cette question, bien qu’il y ait des difficultés tenaces relativement à la capacité institutionnelle de viabilité des ententes liées aux programmes (seulement 6 de 16 évaluations ont obtenu une bonne note).

Lacunes : Bien que la plupart des programmes de l’OMS examinés aient été en mesure de concrétiser leurs objectifs de développement directs, le niveau de couverture des dépenses fourni par les évaluations de l’organisation est assez faible. Par ailleurs, les évaluations de l’OMS étaient souvent axées sur les opérations et l’aspect technique et, même si elles étaient souvent bien conçues selon leurs propres paramètres, elles ne décrivaient pas les changements qui en découlaient pour le groupe cible ou bénéficiaire. La fonction d’évaluation exige un renforcement important afin de couvrir les programmes et les projets de l’OMS et de donner une plus grande assurance que les résultats déclarés pourront être applicables à l’organisation dans son ensemble. Dans le même sens, les évaluations de l’OMS ne comportent pas systématiquement un examen de l’efficacité de ses programmes quant à la contribution à l’égalité entre les sexes.

Afin de renforcer le système d’évaluation de l’OMS, le Conseil exécutif a approuvé la mise en œuvre d’une nouvelle politique d’évaluation lors de sa 131e session tenue les 28 et 29 mai 2012, dans le cadre de la réforme de la gestion de l’organisation.

L’OMS contribue aux priorités de développement du Canada. Il est clairement établi que l’OMS apporte une contribution directe importante aux priorités de développement international du Canada, à savoir accroître la sécurité alimentaire (particulièrement à celle des femmes enceintes et qui allaitent, des enfants et des personnes les plus touchées par les crises) et assurer l’avenir des enfants et des jeunes. Il y a aussi des données probantes qui indiquent que les activités de l’OMS contribuent indirectement à une croissance économique durable en appuyant les systèmes de santé publique et en aidant les pays en développement à réduire le fardeau des maladies transmissibles et non transmissibles.

Recommandations faites à l’ACDI

Cette section présente les recommandations faites à l’ACDI, qui sont fondées sur les constatations et les conclusions tirées de cet examen de l’efficacité de l’aide au développement de l’OMS. Ces recommandations, qui visent à améliorer l’évaluation et la gestion axée sur les résultats à l’OMS, sont conformes aux objectifs liés aux engagements actuels du Canada auprès de l’OMS. Comptant parmi les intervenants qui collaborent avec l’OMS, le Canada, qui a une influence limitée sur l’organisation, pourrait devoir s’allier à d’autres intervenants pour mettre en œuvre ces recommandations. (Voir la réponse de la direction de l’ACDI à l’Annexe 8.)

- Le Canada devrait surveiller les efforts de réforme de la fonction de l’évaluation à l’OMS pendant la mise en œuvre de la nouvelle politique d’évaluation. En particulier, l’ACDI devrait se servir de son influence au Conseil exécutif et auprès d’autres organismes donateurs pour promouvoir une fonction d’évaluation capable et disposant de ressources suffisantes qui peut fournir une bonne couverture de la programmation de l’OMS au fil du temps.

- L’ACDI devrait faire le suivi de la mise en œuvre de la politique d’évaluation afin que les prochaines évaluations de l’OMS abordent suffisamment le thème de l’égalité entre les sexes.

- L’ACDI devrait encourager l’OMS à mettre en place un système de publication de rapports réguliers (peut•être des rapports annuels) sur l’efficacité de l’aide au développement qui s’appuie sur le travail de la fonction d’évaluation réformée. En règle générale, il faut renforcer l’engagement de l’OMS à rendre compte de l’efficacité des programmes.

- L’ACDI devrait encourager l’OMS à gérer systématiquement en fonction des résultats. La mise à niveau constante et une mise en œuvre élargie du Système mondial de gestion à l’OMS pourraient offrir une telle possibilité.

1.0 Introduction

1.1 Contexte

Le présent rapport fait état des résultats d’un examen de l’efficacité de l’aide au développement de l’Organisation mondiale de la santé (OMS) des Nations Unies (ONU). L’approche et la méthode communes employées dans ce rapport ont été élaborées sous la direction du Réseau du Comité d’aide au développement sur l’évaluation du développement (DAC-EVALNET) de l’Organisation de coopération et de développement économiques (OCDE). Deux essais pilotes sur l’OMS et la Banque asiatique de développement ont été menés en 2010 pendant la phase d’élaboration de l’approche et de la méthode communes. Le rapport repose donc sur l’analyse de l’essai pilote des rapports d’évaluation publiés par le Bureau des services de contrôle interne de l’OMS, ainsi que sur un examen des documents organisationnels de l’OMS et de l’ACDI et une consultation avec le gestionnaire de l’ACDI chargé de gérer les relations avec l’OMS.

La méthode utilisée fait appel à un ensemble commun de critères d’évaluation s’inspirant des critères d’évaluation employés par le CAD (Annexe 1). En juin 2011, l’approche et la méthodeNote de bas de page 3 générales ont reçu l’aval des membres du DAC-EVALNET. En effet, ceux-ci ont jugé qu’elles constituaient une approche acceptable pour évaluer l’efficacité de l’aide au développement des organisations multilatérales. Pour simplifier les choses, l’efficacité de l’aide au développement est appelée ci-après « l’efficacité » dans ce rapport.

Dès le départ, le processus de conception et de réalisation des examens de l’efficacité de l’aide au développement et le travail du Réseau d’évaluation du rendement des organisations multilatérales (MOPAN) ont été coordonnés. On s’efforce, dans le cadre des examens, de mettre l’accent sur l’efficacité de l’aide au développement et de sélectionner avec soin les critères d’évaluation afin d’éviter de faire double emploi avec le travail du MOPAN. En règle générale, un examen de l’évaluation de l’efficacité de l’aide au développement se fait la même année qu’une enquête du MOPAN visant une organisation multilatérale donnée. Une enquête du MOPAN sur l’OMS a été menée en 2010 parallèlement à cette analyseNote de bas de page 4.

1.2 Bien-fondé de l’examen

Cet examen offre au Canada et à d’autres intervenants une évaluation indépendante de l’efficacité des programmes de l’OMS en matière d’aide au développement qui est fondée sur des données probantes, évaluation qui sera utile au Canada et à ces autres intervenants. De plus, l’examen répond aux exigences d’évaluation de tous les programmes établis par la Politique sur l’évaluation du gouvernement du Canada.

Les objectifs de l’examen sont les suivants :

- fournir à l’ACDI des données probantes sur l’efficacité de l’aide au développement de l’OMS qui peuvent permettre d’orienter l’engagement actuel du Canada auprès de l’OMSNote de bas de page 5;

- fournir des données sur l’efficacité de l’aide au développement qui pourront être utilisées dans les relations continues entre le gouvernement du Canada et l’OMS, de façon à s’assurer que les priorités du Canada en matière de développement international bénéficient d’investissementsNote de bas de page 6.

Bien que ce rapport ait été préparé, entre autres, dans le but de satisfaire aux exigences en matière de reddition de comptes du Canada au sein du gouvernement du Canada, on s’attend à ce que les résultats soient utiles à d’autres intervenants bilatéraux.

1.3 L’OMS, une organisation mondiale résolue à améliorer la santé

1.3.1 Contexte et objectifs

En tant qu’autorité chargée de diriger et de coordonner l’action sanitaire internationale au sein du système des Nations Unies, l’OMS emploie plus de 8 000 spécialistes de la santé publique, y compris des médecins, des épidémiologistes, des chercheurs, des gestionnaires, des administrateurs et d’autres professionnels. Ces spécialistes de la santé travaillent dans 147 bureaux de pays, six bureaux régionaux et au siège de GenèveNote de bas de page 7. Il y a 194 pays membres de l’OMS et deux membres associés (Porto Rico et Tokelau). Ils se rencontrent chaque année dans le cadre de l’Assemblée mondiale de la santé pour établir les politiques de l’Organisation, approuver le budget et, tous les cinq ans, nommer le directeur général. L’Assemblée mondiale de la santé élit les 34 membres du Conseil exécutif.

Le onzième programme général de travail de l’OMS (2006-2015) définit les fonctions essentielles suivantes de l’Organisation :

- Jouer le rôle de chef de file dans les domaines essentiels pour la santé et créer des partenariats lorsqu’une action conjointe est nécessaire;

- Fixer les priorités de la recherche et inciter à acquérir, à appliquer et à diffuser des connaissances utiles;

- Fixer des normes et des critères, encourager et surveiller leur application;

- Définir des politiques conformes à l’éthique et fondées sur des données probantes;

- Fournir un appui technique, se faire l’agent du changement et renforcer durablement les capacités institutionnelles;

- Surveiller la situation sanitaire et évaluer les tendances.

L’OMS dirige aussi la coordination des interventions humanitaires internationales du groupe mondial responsable de la santéNote de bas de page 8. L’OMS héberge un certain nombre de programmes indépendants et de partenariats public-privé, dont l’Initiative mondiale pour l’éradication de la poliomyélite, le Partenariat Halte à la tuberculose et le Partenariat pour la santé de la mère, du nouveau-né et de l’enfantNote de bas de page 9.

1.3.2 Plan stratégique

Le Plan stratégique à moyen terme de l’OMS énonce 11 objectifs stratégiques de haut niveau pour l’amélioration de la santé mondiale pendant la période 2008-2013. Il inclut aussi deux objectifs stratégiques pour améliorer le rendement de l’OMS. Voici les 11 objectifs stratégiques pour améliorer la santé mondialeNote de bas de page 10 :

1. Réduire le fardeau des maladies transmissibles;

2. Lutter contre le VIH/sida, la tuberculose et le paludisme;

3. Prévenir et réduire les maladies chroniques non transmissibles;

4. Améliorer la santé des mères et des enfants ainsi que la santé sexuelle et génésique, et promouvoir un vieillissement en bonne santé;

5. Réduire les conséquences sur la santé des crises et des catastrophes;

6. Prévenir et réduire les facteurs de risque pour la santé, notamment le tabac, l’alcool, les drogues et l’obésité;

7. S’attaquer aux déterminants sociaux et économiques pour la santé;

8. Favoriser un environnement plus sain;

9. Améliorer la nutrition, de même que la salubrité et la sécurité alimentaires;

10. Améliorer les services et les systèmes de santé;

11. Veiller à accroître l’accès et le recours au matériel médical et aux technologies connexes, de même que la qualité de ceux-ci.

Le Plan stratégique à moyen terme définit aussi deux objectifs orientés sur les rôles et les fonctions propres à l’OMS :

12. Jouer un rôle de chef de file dans le domaine de la santé mondiale, en collaboration avec d’autres partenaires;

13. Faire en sorte que l’OMS soit et demeure une organisation en apprentissage constant.

1.3.3 Champ d’action et couverture géographique

L’OMS est financée par des quotes-partsNote de bas de page 11 et des contributions volontaires de la part des États membres. Le ministère canadien des Affaires étrangères et du Commerce international (MAECI) est responsable des quotes-parts du Canada. À l’instar d’autres organisations de l’OMS, cette dernière prépare un budget biennal qui porte sur les deux années d’activités. Le budget du programme pour le rapport biennal de 2010-2011 était de 4,54 milliards de dollars américains, dont 945 millions de dollars étaient des quotes-partsNote de bas de page 12.

Puisque le budget est composé de quotes-parts et de contributions volontaires, les fonds réels qui sont à la disposition de l’OMS pour régler les dépenses occasionnées par un programme ou une priorité pendant toute une année donnée peuvent être plus élevés ou plus faibles que la somme prévue dans le budget (selon le volume des contributions volontaires). Le Tableau présente le budget approuvé, les fonds réels déclarés comme étant disponibles au cours de la période de deux ans et la somme dépenséeNote de bas de page 13.

| Objectifs stratégiques de l’OMS | Budget approuvé pour 2010-2011 | Fonds disponibles le 31 déc. 2011 | Dépenses au 31 déc. 2011 | % du total des dépenses en 2011 |

|---|---|---|---|---|

| 1. Maladies transmissibles | 1 268 | 1 472 | 1 290 | 35 % |

| 2. VIH/sida, tuberculose et paludisme | 634 | 535 | 446 | 12 % |

| 3. Maladies chroniques non transmissibles | 146 | 112 | 98 | 3 % |

| 4. Santé des enfants, des adolescents et des mères et vieillissement | 333 | 222 | 190 | 5 % |

| 5. Situations d’urgence et catastrophes | 364 | 393 | 312 | 8 % |

| 6. Facteurs de risque pour la santé | 162 | 109 | 94 | 3 % |

| 7. Déterminants sociaux et économiques de la santé | 114 | 42 | 37 | 1 % |

| 8. Environnement plus sain | 63 | 94 | 83 | 2 % |

| 9. Nutrition et sécurité alimentaire | 120 | 70 | 62 | 2 % |

| 10. Systèmes et services de santé | 474 | 348 | 298 | 8 % |

| 11. Matériel médical et technologies connexes | 115 | 158 | 137 | 4 % |

| 12. Rôle de chef de file mondial en matière de santé | 223 | 269 | 264 | 7 % |

| 13. OMS, organisation en apprentissage constant | 524 | 420 | 405 | 11 % |

| TOTAL | 4 540 | 4 244 | 3 717 | 100 % |

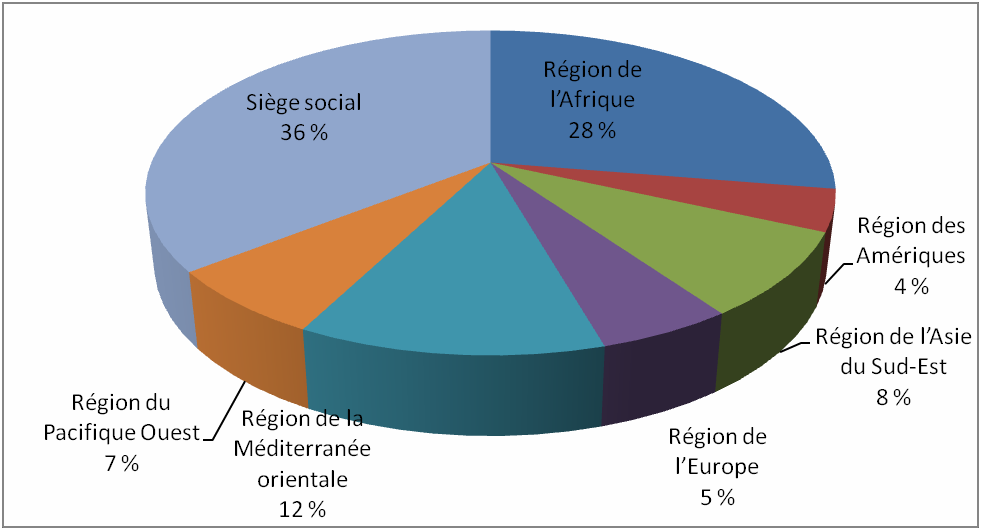

La Figure 1 présente la part des dépenses de 2010 comptabilisée pour chaque région d’activités et pour le siège de l’OMS.

Figure 1 : Part régionale des dépenses de l’OMS en 2010-2011

1.3.4 Évaluations et rapports sur les résultats

Évaluation

La fonction d’évaluation à l’OMS est une responsabilité décentralisée où la plupart des évaluations sont commandées et gérées par des programmes techniques individuels et des bureaux régionaux et de pays. Le Bureau des services de contrôle interne (BSCI) relève directement du directeur général; il mène des vérifications internes, enquête sur des déclarations d’actes répréhensibles et met en œuvre la politique d’évaluation des programmes. Le BSCI est chargé de la fonction d’évaluation.

Lorsque l’essai pilote a été effectué en 2010, les évaluations commandées par l’OMS n’étaient ni publiées en documents imprimés, ni en ligne. On a donc demandé au BSCI de repérer les évaluations pour l’essai pilote et d’en chercher les sources. Le BSCI a indiqué que, dans la plupart des cas, l’OMS et les pays concernés par l’évaluation étaient tous deux responsables des rapports d’évaluation. Des exemplaires devraient être demandés aux bureaux des pays de l’OMS visés. Il n’y avait pas de dépôt central des évaluations publiées offertes en format électronique ou en format imprimé.

En mai 2010, le personnel du BSCI a indiqué qu’un examen important de la politique d’évaluation à l’OMS était en cours et qu’une nouvelle politique et une nouvelle structure seraient élaborées sous peu.

La réorganisation et la restructuration de la politique d’évaluation de l’OMS sont maintenant devenues un élément d’une initiative importante et coordonnée pour réformer la gestion de l’organisation. En prévision d’une session extraordinaire du Conseil exécutif en novembre 2011, le Secrétariat de l’OMS a produit une proposition de cinq éléments qui visent des réformesNote de bas de page 14 en matière de gestion portant sur les domaines suivants :

- « efficacité de l’Organisation, harmonisation et efficience;

- « politiques et gestion [améliorées] dans le domaine des ressources humaines;

- « [plus grandes] planification axée sur les résultats, gestion et responsabilisation;

- « financement [consolidé] de l’Organisation, s’accompagnant d’une stratégie institutionnelle de mobilisation des ressources;

- « cadre stratégique de communication ».

Sous la planification axée sur les résultats, la gestion et la responsabilisation, les réformes liées à la gestion proposées visaient à délimiter « une approche de l’évaluation indépendante ».

Le Conseil exécutif a officiellement adopté la nouvelle politique d’évaluation à sa 131e Session, qui a été tenue en mai 2012Note de bas de page 15. La politique vise à « favoriser une culture de l’évaluation et l’évaluation proprement dite au sein de l’Organisation; à proposer un cadre institutionnel d’évaluation consolidé aux trois niveaux de l’OMS et à faire en sorte que l’évaluation à l’OMS soit conforme aux pratiques exemplaires ainsi qu’aux normes et règles d’évaluation du Groupe des Nations Unies pour l’évaluation ».

La nouvelle politiqueNote de bas de page 16 choisit de renforcer le BSCI plutôt que de créer une nouvelle unité d’évaluation qui relèverait directement du Conseil exécutif. La politique délimite aussi en détail les rôles et les responsabilités du Conseil exécutif, du groupe de travail mondial sur l’évaluation nouvellement créé et du BSCI en ce qui a trait aux évaluations. Elle décrit aussi les principes qui guident tout le travail d’évaluation à l’OMS.

Les nouvelles tâches les plus importantes du BSCI incluent notamment : la préparation d’un plan de travail annuel pour l’évaluation de l’ensemble de l’Organisation; la tenue à jour d’une base de données en ligne des différentes évaluations effectuées à l’OMS; l’assurance que les rapports d’évaluation sont conformes à la politique; la tenue à jour d’un système de suivi de la mise en œuvre des réponses apportées par la direction aux évaluations; la soumission d’un rapport annuel sur les activités d’évaluation au Conseil exécutif, par le biais du directeur général.

Il reste à voir de quelle manière ces propositions seront mises en place et quel effet elles auront sur la force de la fonction d’évaluation à l’OMS. L’introduction de la nouvelle politique proposée décrit l’enjeu auquel est confronté l’OMSNote de bas de page 17 :

« D’un point de vue institutionnel plus large, elle [l’OMS] a moins bien réussi à promouvoir une culture de l’évaluation, à développer les capacités d’évaluation à tous les niveaux de l’Organisation et à appliquer des approches participatives de l’évaluation. Ceci s’explique par les dispositions institutionnelles relatives à l’évaluation (notamment l’absence de mécanisme direct de contrôle par les organes directeurs) et l’absence d’allocation budgétaire effective pour financer l’évaluation. »

L’OMS n’a pas encore fait l’objet d’un examen professionnel par les pairs du CAD et du Groupe des Nations Unies pour l’évaluation, et l’équipe d’examen n’a pas réalisé un tel examen. Cependant, celle-ci a mené son propre examen de la qualité des évaluations pour les inclure dans le rapport.

Les résultats de l’analyse de la qualité par l’équipe d’examen étaient mitigés : 52 % des évaluations examinées ont obtenu une note de 30 points ou plus et 24 % des évaluations ont reçu une note de moins de 19 points sur une possibilité de 48. Pour le critère 1 sur la qualité (les constatations tirées de l’évaluation sont pertinentes et fondées sur des données probantes), seulement trois rapports d’évaluation sur les 25 ont obtenu une note de moins de trois points sur une possibilité de cinq (voir l’Annexe 3, qui explique en détail la méthode d’examen, et l’Annexe 4, qui présente la grille de pointage pour juger la qualité de l’évaluation). Toutes les évaluations ont été conservées pour l’examen, puisque les notes étaient jugées raisonnables dans l’ensemble.

Les rapports d’évaluation de l’OMS étaient souvent axés sur les opérations et l’aspect technique, c’est-à-dire qu’ils portaient sur la mesure dans laquelle une méthode de prestation de service, un système de surveillance ou même l’introduction d’un nouveau vaccin donné était mis en œuvre plutôt que sur les changements qui en découlaient pour le groupe cible ou bénéficiaire. Un problème important se pose lorsqu’il s’agit de juger de la qualité des évaluations, puisque ces études (même si elles étaient souvent bien conçues selon leurs propres paramètres) manquaient souvent des principaux composants d’une évaluation de qualité (tels que les effets sur le groupe cible ou bénéficiaire) lorsqu’elles étaient évaluées en fonction de critères de qualité issus des normes du Groupe des Nations Unies pour l’évaluation.

Bien qu’aucune évaluation n’ait été écartée en raison de préoccupations relatives à la qualité, les rapports d’évaluation ne répondent pas à tous les critères déterminés dans les éléments essentiels à un développement efficace. C’est pourquoi chaque sous-critère examiné plus loin est abordé dans moins de 25 évaluations. Cet examen se penche sur les données disponibles à propos de chaque critère avant de présenter des résultats, et il ne présente pas de résultats pour certains critères.

Rapports sur les résultats

L’OMS ne prépare pas de rapport annuel sur l’efficacité de l’aide au développement ou de résumé annuel des résultats d’évaluation. Elle fournit cependant chaque année de nombreux rapports sur la situation mondiale et régionale en matière de santé à l’Assemblée mondiale de la santé. Elle présente aussi chaque année des rapports spéciaux sur des sujets précis d’intérêt planétaire et des questions touchant la santé publique. Tous les deux ans, l’OMS publie un rapport d’évaluation du rendement qui décrit la mesure dans laquelle elle a atteint ses objectifs et sous-objectifs stratégiques au cours des deux dernières années.

Système mondial de gestion

Depuis quelques années, l’OMS met en œuvre un système de suivi et de compte rendu des résultats fondé sur le système de gestion de base de données Oracle. Ce Système mondial de gestion existe depuis 2008 et est actuellement mis à jour après une longue phase de mise en œuvre. Il a pour but de mettre la planification, la mise en œuvre et le suivi des programmes et des projets en adéquation avec les objectifs stratégiques de l’agence au niveau ministériel, régional et national.

Depuis 2008, l’OMS a fait un effort pour mettre en place le système dans chaque région et, en janvier 2011, elle a pu informer le Conseil d’administration qu’elle avait réalisé des « progrès importants » dans la mise en œuvre du système dans cinq régions et à son siège. Le Conseil exécutif (EB128/3) était satisfait des progrès réalisés, mais le fait que la Région des Amériques/l’Organisation panaméricaine de la santé (OPS) ait choisi de ne pas utiliser ce système le préoccupait.

En mai 2011, le secrétariat de l’OMS a fait rapport des progrès réalisés dans la mise en œuvre du Système mondial de gestion au Comité du Programme, du Budget et de l’Administration au Conseil exécutif. Voici ce qu’on peut lire dans le rapport du comité au Conseil exécutif Note de bas de page 18 :

« Le Comité s’est déclaré satisfait que le Système mondial de gestion ait été mis en place avec succès dans la Région africaine. Des questions ont été posées concernant la mise à jour prévue du Système et les coûts qu’elle entraînerait ainsi que les économies qui résulteront de sa mise en œuvre. Des questions ont également été posées au sujet de l’harmonisation entre le Système mondial de gestion et le nouveau système mis en place dans la Région des Amériques/à l’OPS. »

Selon la documentation actuellement disponible au sujet de ce système, il mettrait toujours l’accent sur les finances, l’administration, la planification de l’affectation des ressources et la gestion des ressources humaines. On ne sait pas encore si le système permettra de consolider le système de gestion et de présentation des résultats utilisé à l’OMS.

Lors de la Session extraordinaire sur la réforme de l’OMS, tenue en novembre 2011, le Conseil exécutif a accueilli avec satisfaction les propositions du directeur général relatives aux réformes gestionnaires et a demandé qu’il soit donné suite à plusieurs propositions, notamment celle visant à améliorer la surveillance et la notificationNote de bas de page 19. Tel que mentionné, à la suite de cette demande, on a proposé de créer une politique sur l’évaluation, que le Comité exécutif a officiellement adoptée lors de sa réunion de mai 2012. On ne sait pas encore si cette politique renforcera les exigences en matière d’établissement de rapports sur l’efficacité des programmes de l’OMS et surpassera celles qui s’appliqueraient dès la mise en œuvre complète du Système mondial de gestion.

Enfin, il faut tenir compte du fait que l’OMS a publié un rapport d’évaluation du rendement en mai 2012 pour faire le suivi des indicateurs de mesure des progrès visant l’atteinte des objectifs et sous-objectifs stratégiques au cours des deux dernières annéesNote de bas de page 20. Un rapport semblable a été publié en 2010. Bien que les rapports ne fournissent que des renseignements mondiaux (et parfois régionaux) et qu’ils ne décrivent pas la méthode employée pour faire le suivi et la vérification des indicateurs, ils représentent un excellent pas dans la bonne direction en vue de la reddition de comptes sur le rendement de l’OMS.

2.0 Méthode

La présente section décrit brièvement les éléments principaux de la méthode employée pour effectuer l’examen. Une description plus détaillée de cette méthode se trouve à l’Annexe 3.

2.1 Raison d’être

En tant qu’importante organisation des Nations Unies, l’OMS a été choisie pour l’essai pilote de l’approche commune, de même que la Banque asiatique de développement (en tant que banque de développement multilatérale). Le fait que l’OMS ait été choisie a permis de faire un essai de l’approche sur un organisme spécialisé des Nations Unies ayant un fort mandat social. Les membres du DAC-EVALNET ont aussi manifesté un intérêt marqué pour l’examen de l’efficacité de l’OMS en tant qu’organisation essentielle aux efforts pour atteindre les Objectifs du Millénaire pour le développement (OMD) relatifs à la santé.

Le terme « approche commune » décrit le recours à une méthode standard, comme celle utilisée dans le présent examen, pour évaluer de manière uniforme l’efficacité de l’aide au développement des organisations multilatérales. Cette approche fournit un moyen économique et rapide d’évaluer l’efficacité, comparativement à une évaluation conjointe, qui est plus coûteuse et prend plus de tempsNote de bas de page 21. Elle a été élaborée dans le but de combler une lacune concernant l’efficacité des organisations multilatérales. Bien que ces organisations produisent des rapports annuels à l’intention de leur équipe de direction ou de leur conseil d’administration, les intervenants bilatéraux n’ont pas une vue d’ensemble exacte du rendement de ces organisations sur le terrain. Pour régler ce problème, le Réseau d’évaluation du rendement des organisations multilatérales (MOPAN) a entrepris des évaluations de l’efficacité organisationnelle. Cette approche complète les évaluations du MOPAN.

Selon l’approche commune, deux conditions particulières justifient la réalisation d’un examen fondé sur les rapports d’évaluation internes de l’organisationNote de bas de page 22 :

- La nécessité de renseignements fondés sur des données probantes, mis à l’essai sur le terrain, concernant l’efficacité de l’organisation multilatérale.

- L’organisation multilatérale à l’étude a une fonction d’évaluation qui produit un ensemble adéquat de données sur l’évaluation, fiables et crédibles, lesquelles appuient l’utilisation d’une méthode de métaévaluation permettant de faire la synthèse d’une évaluation de l’efficacité de l’organisation.

L’OMS a rempli l’une des deux exigences pour mener à bien un examen de l’efficacité au moment de l’essai pilote. On a clairement besoin de plus de renseignements fondés sur des données probantes, mis à l’essai sur le terrain, concernant l’efficacité de la programmation de l’OMS. Les résultats du deuxième essai étaient plus marginaux. La disponibilité de rapports d’évaluation de qualité raisonnable au moment de l’essai pilote était limitée, seulement 25 évaluations de la sorte ont été fournies par l’OMS au cours de la période 2007•2010 à l’équipe responsable de l’essai pilote. L’examen a été réalisé parce que ces 25 évaluations avaient pu aborder modérément quatre des six principaux critères employés pour évaluer l’efficacité. Cependant, cette faible quantité d’évaluations raisonnables limite la mesure dans laquelle les résultats peuvent être généralisés pour l’ensemble de l’organisation.

2.2 Portée

L’échantillon de 25 évaluations disponibles pour cet examen de l’OMS offre une couverture limitée du budget de programmation de plus de 4,5 milliards de dollars américains disponible pendant la période de deux ans (2010-2011). Il est difficile d’estimer le niveau de couverture fourni puisque les rapports d’évaluation ne donnent souvent pas de données sur la valeur globale des programmes évalués. Néanmoins, les évaluations montrent la portée à l’échelle nationale, régionale et mondiale ou thématique, et il y a certains liens intéressants entre l’échantillon et le profil du budget de l’OMS.

- Les maladies transmissibles (objectif stratégique 1) : 8 des 25 évaluations portaient sur la mise en œuvre de programmes élargis de vaccination dans toute un éventail de pays (République centrafricaine, République démocratique du Congo, Cameroun, Vietnam, Sierra Leone, Zambie et Philippines). Ces programmes contribuent directement au plus important objectif stratégique de l’OMS, en termes de valeur monétaire.

- Urgences et catastrophes (objectif stratégique 5) : 3 des 25 évaluations portaient sur l’intervention sanitaire en cas de crise dans une région ou un pays donné : 1 en Afrique, 1 au Myanmar et 1 en Palestine. (De plus, une évaluation de programme sur les interventions sanitaires en cas de crise était incluse dans la catégorie générale ci-dessous). Ces programmes contribuent au troisième objectif stratégique en importance en termes de financement.

- Un grand nombre d’évaluations examinées sont de portée générale ou organisationnelle. Elles comprennent entre autres :

- l’évaluation du département Pour une grossesse à moindre risque (2010);

- l’évaluation indépendante des principaux obstacles à l’interruption de la transmission du poliovirus (2009);

- l’évaluation indépendante du partenariat Halte à la tuberculose (2008);

- l’examen des programmes de nutrition de l’OMS à la lumière des défis planétaires et de la structure internationale de la nutrition (2008);

- l’évaluation de la mise en œuvre, des répercussions et des processus de la Stratégie pharmaceutique de l’OMS (2007);

- l’évaluation du Programme de renforcement institutionnel d’Interventions sanitaires en cas de crise (2007);

- l’évaluation des programmes – Aspects choisis du département de Santé publique et environnement (2007);

- l’évaluation thématique de la collaboration entre l’OMS et les centres partenaires (2007).

Cet examen porte sur des évaluations qui ont toutes été produites par l’OMS pendant la période qui s’étend du début de 2007 au milieu de 2010, moment où l’examen a été effectué (Annexe 3). Bien que certaines évaluations portent sur des programmes qui peuvent avoir eu lieu avant 2007, la plupart des activités de programmes de l’OMS abordées dans les évaluations examinées ont eu lieu entre 2007 et 2010. L’équipe d’examen a aussi analysé certains documents de l’OMS publiés en 2011 et au début de 2012 pour faire une mise à jour de certaines constatations tirées des évaluations examinées.

En somme, bien que la liste des évaluations appropriées pour l’examen que l’équipe de l’essai pilote a obtenue de l’organisation ne puisse se comparer aisément à la distribution des activités sur le plan géographique et de la programmation, elle fournit du moins un ensemble partiel de matériel d’évaluation testé sur le terrain portant sur l’efficacité. Pour cette raison (et pour apprendre les leçons qui pourraient être tirées de la réalisation de cette étude), l’équipe a effectué l’examen de l’efficacité (essai pilote) de l’OMS.

Outre les 25 évaluations, l’examen comportait une revue de documents stratégiques et de reddition de comptes pertinents de l’OMS, tels que les rapports du Comité du programme, du budget et de l’administration au Conseil exécutif, les rapports sur la réforme de l’OMS par le directeur général, des documents sur la politique d’évaluation, des rapports annuels et l’évaluation provisoire du plan stratégique à moyen terme (voir l’Annexe 6). Ces documents ont permis à l’équipe d’examen de juger de l’évolution permanente de l’évaluation et de la reddition de comptes sur les résultats à l’OMS et de mettre les constatations dans le contexte dans les rapports d’évaluation.

L’équipe d’examen a aussi mené une entrevue auprès du personnel du Bureau des services de contrôle interne (BSCI) à l’OMS pour mieux comprendre l’univers des rapports d’évaluations disponibles de l’OMS et mettre en contexte la situation changeante de la fonction d’évaluation. Enfin, l’équipe d’examen a mené une entrevue avec le gestionnaire de l’ACDI le plus directement responsable de la relation soutenue entre l’ACDI et l’OMS afin de mieux évaluer la contribution des organisations aux priorités de développement international du Canada.

2.3 Critères

La méthode employée ne repose pas sur une définition particulière de l’efficacité de l’aide au développement. Le groupe de gestion et le groupe de travail mis sur pied par le DAC-EVALNET dans le but de développer la méthode ont déjà cherché à déterminer s’il fallait formuler une définition explicite de l’efficacité. En l’absence d’une définition convenue de l’efficacité, la méthode vise l’évaluation de quelques-unes des caractéristiques essentielles qui permettent de démontrer l’efficacité des programmes des organisations multilatérales sur le plan du développement. Ces caractéristiques sont les suivantes :

- Pertinence des interventions : les programmes sont adaptés aux besoins des membres du groupe cible;

- Atteinte des objectifs de développement et des résultats escomptés : les programmes contribuent à l’atteinte des objectifs de développement et des résultats de développement escomptés à l’échelle nationale et locale dans les pays en développement;

- Viabilité des résultats et des bienfaits : les bienfaits pour les membres du groupe cible et les résultats en matière de développement obtenus sont durables;

- Efficacité : les programmes sont exécutés de façon efficace et rentable;

- Thèmes transversaux (viabilité environnementale et égalité entre les sexes) : les programmes sont inclusifs en ce sens qu’ils appuient l’égalité entre les sexes et sont viables du point de vue environnemental (ainsi, ils ne compromettent pas les perspectives de développement futur);

- Amélioration de l’efficacité à l’aide de l’évaluation et du suivi : les programmes contribuent efficacement au développement en permettant aux organismes participants et aux organisations qui appuient le développement de tirer parti des expériences antérieures et d’utiliser des outils de gestion du rendement et de responsabilisation, comme l’évaluation et le suivi de l’amélioration de l’efficacité au fil du temps.

La méthode utilisée pour l’examen fait donc appel à une métasynthèse systématique et structurée des constatations tirées d’évaluations de l’OMS, en fonction de 6 critères principaux et de 18 sous-critères qui sont considérés comme des éléments essentiels à un développement efficace (Annexe 5). Les principaux critères et sous-critères s’inspirent des critères d’évaluation du CAD.

2.4 Limites

Comme c’est toujours le cas avec les métaévaluations, des problèmes de nature méthodologique peuvent survenir et restreindre les constatations. Dans le cas du présent examen, les contraintes de nature méthodologique visent, notamment, les biais d’échantillonnage, la difficulté d’assurer une couverture adéquate des critères employés et les problèmes de classification des constatations tirées des évaluations.

La principale limite de cet examen de l’OMS vise le nombre de rapports d’évaluation disponibles au BSCI central et mis à la disposition de l’équipe responsable de l’examen en 2010 (couvrant la période allant de 2007 à 2010). L’ensemble des rapports d’évaluation disponibles et valides ne fournit pas, cependant, une couverture suffisante des programmes et des activités de l’OMS pendant la période pour permettre une généralisation des résultats des programmes de l’OMS dans son ensemble. Les 25 rapports d’évaluations disponibles fournissent cependant des impressions sur l’efficacité des programmes de développement de l’OMS évalués pendant cette période.

Une autre contrainte vient du fait que bon nombre de ces 25 évaluations n’abordent pas certains des sous-critères employés pour évaluer l’efficacité. Puisque les contraintes viennent du petit nombre d’évaluations disponibles et du manque de couverture de certains sous-critères, les constatations sont relevées plus bas seulement pour les critères dont la couverture a été cotée comme étant forte ou modérée.

3.0 Constatations relatives à l’efficacité de l’aide au développement de l’OMS

Pas suffisamment de données probantes pour tirer des conclusions sur l’OMS

La principale contrainte de cet examen était qu’il n’y avait que 25 rapports d’évaluation disponibles au BSCI central qui ont été mis à la disposition de l’équipe responsable de l’examen. Ce petit échantillon ne fournit pas une couverture suffisante des programmes et des activités de l’OMS pour permettre de généraliser les résultats à l’OMS dans son ensemble.

De plus, le nombre limité de rapports d’évaluation n’a pas permis aux examinateurs de contrôle le biais de sélection dans l’échantillon des évaluations. Cet enjeu est accentué par le fait que les rapports d’évaluation ne présentent pas toujours le rapport du budget du programme qui a été évalué.

Enfin, de nombreuses évaluations disponibles n’abordaient pas les sous-critères employés dans cet examen pour évaluer l’efficacité, ce qui limitait la quantité de renseignements sur lesquels cet examen pouvait faire le rapport.

Prises ensemble, ces contraintes font qu’il n’y a pas assez de renseignements pour tirer des conclusions sur l’efficacité de l’aide au développement de l’OMS. Cependant, dans l’intérêt de fournir des renseignements utiles et de synthèse, certaines constatations sont présentées plus bas.

Politique d’évaluation de 2012 de l’OMS

Une analyse de la politique d’évaluation de 2012 de l’OMS (section 3.6.4) indique que, bien que l’approbation d’une politique d’évaluation représente un pas positif, des lacunes demeurent dans la politique pour ce qui est de la planification, de l’établissement de priorités, de la budgétisation et de la divulgation des évaluations de l’OMS.

Un examen du Corps commun d’inspection des Nations Unies a aussi soulevé des inquiétudes à l’égard de l’indépendance et de la crédibilité des évaluations de l’OMS; selon cet examen, l’OMS devrait avoir une meilleure capacité d’évaluation centrale. On y recommande également qu’un examen par les pairs de la fonction d’évaluation soit mené par le Groupe des Nations Unies pour l’évaluation et présenté au Conseil exécutif de l’OMS d’ici 2014.

Observations sur l’efficacité de l’aide au développement de l’OMS

La présente section fait état des résultats de l’examen de l’efficacité de l’aide au développement relativement aux six critères principaux, et aux sous-critères qui leur sont associés (Tableau 2 et Annexe 5). En particulier, le tableau présenté ci-dessous décrit les cotes « Satisfaisant » et « Insatisfaisant » attribuées par l’équipe d’examen à chacun des six critères principaux, ainsi qu’aux sous-critères qui s’y rattachent. On y trouve également le nombre d’évaluations où chaque sous-critère est abordé (représenté par la lettre a)Note de bas de page 23.

Aucun résultat n’est fourni pour les sous-critères abordés dans moins de dix évaluations. Lorsque la couverture d’un sous-critère donné est solide (c’est-à-dire que ce sous-critère est abordé dans 18 à 25 rapports d’évaluation) ou modérée (ce sous-critère est abordé dans 10 à 17 rapports), les résultats sur l’efficacité sont présentés.

Chacune des sections suivantes commence par un résumé de la couverture des critères et sous-critères et des principales constatations, et est suivie des principaux facteurs qui ont eu une incidence sur ces résultats. Une quantification du nombre d’évaluations qui abordent un facteur en particulier décrit l’importance des facteurs positifs et négatifs qui contribuent aux résultats pour chaque critère évalué.

| Sous-critères | a* | Couverture** | Évaluations cotées satisfaisantes (%)*** | Évaluations cotées insatisfaisantes (%)*** |

|---|---|---|---|---|

| *a = nombre d’évaluations abordant le sous-critère étudié. ** Couverture définie ainsi : Solide a = 18-25, Modérée a = 10-17, Faible a = moins de 10 ***Les cotes « satisfaisant » sont : « satisfaisant » et « très satisfaisant »; les cotes « insatisfaisant » sont : « insatisfaisant » et « très insatisfaisant ». | ||||

| Pertinence des interventions | ||||

| 1.1 Les programmes répondent aux besoins des membres du groupe cible. | 18 | Solide | 89 % | 11 % |

| 1.2 Les programmes s’alignent sur les objectifs nationaux en matière d’aide humanitaire et de développement. | 12 | Modérée | 100 % | 0 % |

| 1.3 Des partenariats efficaces sont établis avec les gouvernements. | 18 | Solide | 61 % | 39 % |

| 1.4 Les objectifs des programmes demeurent valides. | 21 | Solide | 100 % | 0 % |

| 1.5 Les activités des programmes sont conformes aux objectifs des programmes. | 20 | Solide | 60 % | 40 % |

| Atteinte des objectifs de développement et des résultats escomptés | ||||

| 2.1 Les programmes et les projets atteignent leurs objectifs. | 21 | Solide | 71 % | 29 % |

| 2.2 Effets positifs sur les membres du groupe cible. | 14 | Modérée | 64 % | 36 % |

| 2.3 Nombre important de bénéficiaires | 8 | Faible | S.O. | S.O. |

| Viabilité des résultats et des bienfaits | ||||

| 3.1 Les bienfaits se maintiendront probablement après la fin du programme. | 11 | Modérée | 73 % | 27 % |

| 3.2 Les programmes appuient les capacités institutionnelles en matière de viabilité | 16 | Modérée | 37 % | 63 % |

| Efficacité | ||||

| 4.1 Des programmes sont évalués comme étant rentables. | 9 | Faible | S.O. | S.O. |

| 4.2 La mise en œuvre et les objectifs des programmes sont réalisés dans les délais prévus. | 5 | Faible | S.O. | S.O. |

| Thèmes transversaux : Développement à la fois inclusif et durable (égalité entre les sexes et viabilité de l’environnement) | ||||

| 5.1 Les programmes tiennent compte efficacement de la question de l’égalité entre les sexes. | 0 | Faible | S.O. | S.O. |

| 5.2 Les changements sont écologiquement viables. | 1 | Faible | S.O. | S.O. |

| Recours à l’évaluation et au suivi pour améliorer l’efficacité de l’aide au développement | ||||

| 6.1 Les systèmes et les processus d’évaluation sont efficaces. | 16 | Modérée | 44 % | 56 % |

| 6.2 Les systèmes et les processus de suivi sont efficaces. | 19 | Solide | 42 % | 58 % |

| 6.3 Les systèmes et les processus de gestion axée sur les résultats sont efficaces. | 3 | Faible | S.O. | S.O. |

| 6.4 Les résultats de l’évaluation sont utilisés pour améliorer l’efficacité de l’aide au développement. | 9 | Faible | S.O. | S.O. |

3.1 Les programmes de l’OMS semblent cadrer avec les besoins des intervenants et les priorités nationales

3.1.1 Couverture des sous-critères

Comme le montre la Figure , les évaluations examinées abordent le sujet pertinent; quatre des cinq sous-critères (soit 1.1, 1.3, 1.4 et 1.5) ont obtenu une cote « élevée » au chapitre de la couverture. La couverture pour un sous-critère (soit 1.2) a reçu la cote « modérée », car ce sous-critère a été abordé dans 12 évaluations.

Figure 2 : Nombre d’évaluations abordant le sous-critère de la pertinence

3.1.2 Principales constatations

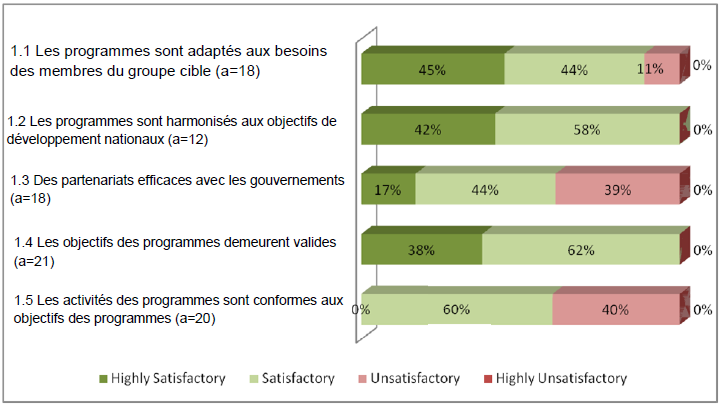

En somme, les évaluations examinées accordent une cote « élevée » aux projets et aux programmes appuyés par l’OMS sur une échelle de pertinence. En particulier, les programmes évalués répondent bien aux besoins des membres du groupe cible, sont harmonisés aux priorités nationales et leurs objectifs demeurent valides au fil du temps, comme le décrit la Figure 3 qui suit.

Pour ce qui est de savoir si les programmes et les projets financés par l’OMS sont adaptés aux besoins des membres du groupe cible (sous-critère 1.1), l’examen a permis de constater dans 16 des 18 rapports d’évaluation qui abordaient ce critère (soit 89 %) que les constatations étaient considérées comme satisfaisantes ou mieux, et que la moitié de ces évaluations lui donnait la cote « très satisfaisant ». Les 12 évaluations qui abordaient la question de l’harmonisation des programmes financés par l’OMS aux priorités et aux objectifs de développement nationaux (sous-critère 1.2) étaient cotées « satisfaisant » ou mieux.

Plus d’évaluations ont jugé le sous-critère 1.3 (l’efficacité des partenariats à tous les ordres de gouvernement); 11 des 18 évaluations (soit 61 %) l’ont coté « satisfaisant » ou mieux. Cependant, 7 évaluations (39 %) étaient cotées « insatisfaisant ».

Les 20 évaluations qui abordaient le sous-critère 1.4 sur la validité continue des objectifs des programmes ont relevé des constatations satisfaisantes ou mieux. La question de la correspondance entre les objectifs des programmes et les activités des programmes (sous-critère 1.5) n’était pas si claire; en effet, seulement 12 des 20 rapports d’évaluation (soit 60 %) ont déclaré que les constatations étaient satisfaisantes. Ces résultats reflètent aussi la nature technique de certaines évaluations de l’OMS, qui n’ont pas permis à l’équipe d’examen de vérifier que l’élaboration des projets incluait une évaluation systématique des liens de cause à effet entre les activités et extrants de programmes et les objectifs atteints.

Les conclusions de cet examen et celles de l’enquête du MOPAN de 2010 concordent sur le sujet de pertinenceNote de bas de page 24. L’OMS s’est classée au sommet de l’indicateur « adéquat » du MOPAN pour ce qui est des « résultats élaborés en consultation avec les bénéficiaires » et « fort » pour les indicateurs « résultats escomptés conformes aux stratégies de développement nationales » et « appuient les plans nationaux ».

Figure 3 : Pertinence des interventions (constatations en pourcentage du nombre d’évaluations qui abordent le sous-critère a, sur un total de 25 évaluations)

L’encadré ci-dessous illustre les résultats obtenus pour le critère 1.2, « Les programmes s’alignent sur les objectifs nationaux en matière de développement », comme on le fait remarquer dans l’évaluation de la santé des enfants au Guyana.

Encadré 1

Harmonisation aux priorités nationales au Guyana

Un plan stratégique national pour la réduction de la mortalité maternelle et néonatale (2006-2012) a été élaboré; il est axé sur l’atteinte des cibles des OMD relatives à la mortalité fixées lors de la Session extraordinaire de l’Assemblée générale des Nations Unies en 2000. L’amélioration de l’état de santé des mères et des enfants est aussi mise en priorité dans le plan national de santé (2003-2007) et le cadre stratégique de lutte contre la pauvreté (2002).

Examen de la santé des enfants au Guyana

3.1.3 Facteurs déterminants

Deux facteurs importants ont contribué aux conclusions positives de l’évaluation dans le domaine de la pertinence :

- l’expérience de l’OMS à faire correspondre l’élaboration des programmes au fardeau (morbidité et mortalité) des maladies dans les pays où les programmes sont exécutés (11 évaluations)Note de bas de page 25;

- les consultations avec des intervenants clés à l’échelle nationale et locale pour veiller à ce que l’élaboration des programmes corresponde aux besoins des utilisateurs et aux priorités nationales.

L’encadré 2 fournit un exemple de la manière dont les consultations mondiales ont servi à définir le cadre des interventions de l’OMS dans les programmes d’interventions sanitaires en cas de crises dans les pays touchés par une crise.

Un certain nombre de facteurs ont contribué à quelques constatations insatisfaisantes tirées des évaluations dans le domaine de la pertinence :

- relations et responsabilités peu claires chez les gouvernements et les organisations non gouvernementales participants (2 évaluations);

- manque de coordination chez les organisations de soutien (OMS et Bureau de coordination des affaires humanitaires de l’ONU, par exemple), ce qui complique la coordination avec les partenaires d’administrations régionales et locales (1 évaluation);

- faible capacité des partenaires gouvernementaux et non gouvernementaux (1 évaluation);

- malentendus avec les programmes quant aux rôles des différents organismes et des différentes unités du gouvernement (1 évaluation).

Encadré 2

Consultations servant à définir le soutien institutionnel pour les interventions sanitaires en cas de crise

En 2005, un processus de consultation auquel ont participé plus de 300 intervenants dans le monde a permis de définir quatre fonctions de base du travail de l’OMS dans les pays touchés par une crise. Ce cadre a été approuvé par la résolution WHA58.1 de l’Assemblée mondiale de la santé, en 2005. La première fonction de base a été d’évaluer rapidement les besoins en matière de santé des populations touchées par une crise. Ceci a été considéré comme étant particulièrement bien compris et mise en œuvre. Dans l’évaluation, nous avons remarqué une satisfaction accrue à la suite de l’amélioration de la capacité de l’OMS pour l’évaluation des besoins et ce, dans tous les pays visés, bien que les besoins soient toujours plus grands que les ressources.

Évaluation du programme de renforcement des institutions visant les interventions sanitaires en cas de crise

3.2 L’OMS semble avoir atteint ses objectifs de développement et les résultats escomptés

3.2.1 Couverture

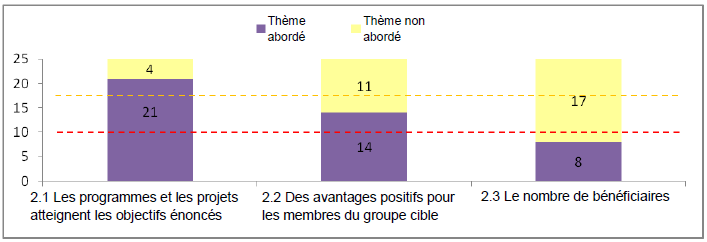

Deux des trois sous-critères de l’atteinte des objectifs et des résultats escomptés ont une couverture forte (sous-critère 2.1) ou modérée (sous-critère 2.2.). Comme l’illustre la Figure , la couverture du sous-critère 2.3 (Les programmes et les projets améliorent la situation d’un nombre considérable de bénéficiaires) était faible, puisque seulement huit évaluations abordaient le nombre de bénéficiaires des programmes.

Figure 4 : Nombre d’évaluations où les sous-critères relatifs à l’atteinte des objectifs sont abordés

3.2.2 Principales constatations

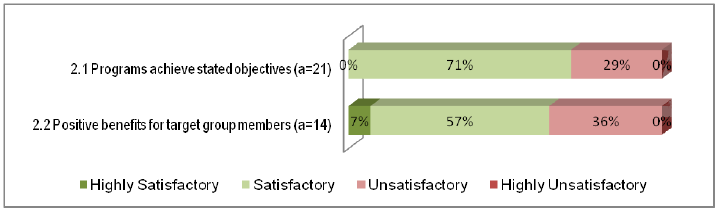

En somme, les évaluations examinées indiquent que les programmes de l’OMS atteignent leurs objectifs relatifs au développement et qu’ils permettent d’obtenir des avantages pour les membres du groupe cible désigné.

Des 21 rapports d’évaluation qui abordent le sous-critère 2.1 (les programmes et les projets atteignent les objectifs énoncés), 15 évaluations (71,4 %) indiquent que les constatations sont satisfaisantes, tandis que seulement six évaluations (28,6 %) ont été notées comme étant insatisfaisantes. Les programmes de l’OMS ont aussi permis d’obtenir des avantages pour les membres du groupe cible, comme le font remarquer les constatations de 9 des 14 évaluations (64 %) qui abordent le sous-critère 2.2.

Figure 5 : Résultats quant à l’atteinte des objectifs (constatations en pourcentage du nombre d’évaluations qui abordent le sous-critère a sur un total de 25 évaluations)

Les encadrés 3 et 4 illustrent la manière dont les programmes de l’OMS atteignent leurs objectifs de développement. L’Encadré 3 indique que l’OMS était en mesure de jouer un rôle de courtage neutre afin de jouer un rôle de chef de file dans la coordination du groupe des Nations Unies responsable de la santé pendant les opérations d’urgence en Afrique. L’encadré 4 donne un exemple des programmes de l’OMS qui contribuent aux résultats positifs visant la santé des nouveau-nés et des enfants au Cambodge.

Encadré 3

Interventions sanitaires en cas de crise de l’OMS en Afrique

L’évaluation a permis de constater que l’OMS est en mesure de mettre son rôle de courtage neutre en pratique sans nuire à son mandat organisationnel. L’évaluation confirme que l’OMS peut mettre en œuvre son rôle de chef de file dans la coordination du groupe responsable de la santé. Les bureaux dans les pays fournissent un bon appui aux partenaires en ce qui a trait aux évaluations des besoins, aux résultats de santé et aux enquêtes sur les services de santé et à la fourniture de données de surveillance régulières sur les maladies.

Évaluation du travail lié aux interventions sanitaires en cas de crise en Afrique

3.2.3 Facteurs déterminants

Deux facteurs communs ont été observés dans les évaluations comme déterminant l’atteinte des objectifs de développement dans les programmes de l’OMS :

- des éléments techniques solides dans l’élaboration des programmes qui correspondent aux interventions dans les programmes pour alléger le fardeau des maladies (11 évaluations);

- des niveaux élevés de prise en charge à l’échelle nationale et locale à la suite de processus de consultation de l’élaboration de programmes (4 évaluations).

Lorsque les évaluations ont permis d’observer que les avantages pour les membres du groupe cible manquaient ou étaient limités dans leur portée, les évaluations ont permis de constater :

- une mise en œuvre faible ou retardée (2 évaluations);

- un manque de financement adéquat et de ressources humaines investis dans le programme (1 évaluation);

- des retards dans la hausse prévue de financement de la part des donateurs (1 évaluation).

3.3 Les avantages des programmes de l’OMS semblent être durables, mais le maintien des capacités de ses partenaires suppose des difficultés

3.3.1 Couverture des sous-critères

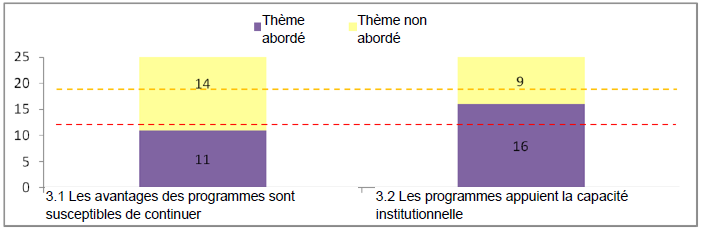

Les évaluations ont fourni un niveau de couverture modéré pour les sous-critères d ’évaluation de la viabilité. Le sous-critère 3.1 (les avantages des programmes sont susceptibles de continuer) a été abordé par 11 rapports d’évaluation, tandis que le sous-critère 3.2 (les programmes appuient la capacité institutionnelle) a été abordé dans 16 des 25 rapports d’évaluation.

Figure 6 : Nombre de rapports d’évaluation qui ont abordé les sous-critères relatifs à la viabilité

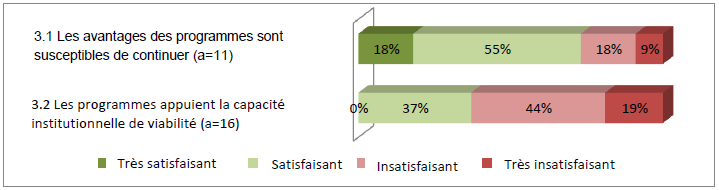

3.3.2 Principales constatations

Les constatations relatives à la viabilité reflètent un niveau de rendement mitigé (Figure 7). Les évaluations examinées indiquent que les avantages des programmes de l’OMS sont durables, mais qu’il y a des enjeux importants pour s’assurer que les dispositions institutionnelles pour la prestation continue des programmes sont durables. Pour le sous-critère 3.1 (les avantages des programmes sont susceptibles de continuer), 8 des 11 rapports d’évaluation (73 %) font état de constatations satisfaisantes ou mieux. À l’opposé, pour le sous-critère 3.2 (les programmes appuient la capacité institutionnelle), seulement 37 % des évaluations font état de constatations positives, puisque 10 des 16 évaluations ont donné une note insatisfaisante ou plus faible.

Figure 7 : Viabilité des résultats et des bienfaits (résultats exprimés sous forme de pourcentage du nombre d’évaluations abordant le sous-critère a sur un total de 25 évaluations)

3.3.3 Facteurs déterminants

Trois facteurs ont été mentionnés dans les évaluations comme contribuant à la viabilité des résultats des programmes de l’OMS :

- une prise en charge à l’échelle nationale et locale forte (4 évaluations);

- des processus de consultation pour déterminer les principaux enjeux en matière de santé et s’entendre sur les dispositions de mise en œuvre de solutions (4 évaluations);

- l’utilisation des réseaux locaux pour maintenir la réussite des dispositions des programmes de vaccination.

Deux facteurs ont été déterminés comme contribuant à des résultats moins que satisfaisants quant à la viabilité :

- l’absence de ressources financières adéquates et soutenues des gouvernements et des donateurs pour maintenir les services des programmes au niveau actuel (1 évaluation);

- des problèmes liés à l’interruption de services de l’OMS dans des pays et des régions en crise (1 évaluation).