Méta-évaluation des évaluations décentralisées d’Affaires mondiales Canada

Mars 2017

Table des matières

- Remerciements

- Liste des acronymes et des abréviations

- Sommaire exécutif

- Réponse de la direction

- 1 Introduction

- 2 Objectifs et portée

- 3 Évaluabilité

- 4 Méthodologie

- 5 Constatations

- 5.1 Qualité des évaluations décentralisées

- 5.2 Aspects de la qualité des documents d’évaluation d’AMC qui dépassent les normes du CAD ou qui n’y répondent pas

- 5.3 Qualité des processus de planification des évaluations décentralisées

- 5.4 Utilisation des évaluations décentralisées

- 5.5 Mise en application des recommandations de la méta-évaluation de 2008

- 5.6 Examen des systèmes de gestion de l’information d’AMC

- 6 Conclusions

- 7 Leçons

- 8 Recommandations

Remerciements

La Direction de l’évaluation du développement d’Affaires mondiales Canada tient à remercier toutes les personnes qui ont contribué à la présente évaluation, notamment les collègues du Groupe de travail sur l’évaluation du développement et tous les autres qui ont offert leur soutien et leurs conseils tout au long du processus d’évaluation.

L’évaluation a été menée par une équipe indépendante d’Itad Limited. La Direction de l’évaluation du développement a assuré l’encadrement et la gestion du processus d’évaluation.

David Heath

Chef, Évaluation du développement

Liste des acronymes et des abréviations

- ACDI

- Agence canadienne de développement international

- AMC

- Affaires mondiales Canada

- BID

- Banque Interaméricaine de Développement

- CAD

- Comité d’aide au développement (de l’OCDE)

- CARTAC

- Centre régional d'assistance technique pour les Caraïbes

- DED

- Direction de l’évaluation du développement

- DFAT

- Department for Foreign Affairs and Trade (Australia) / Ministère des Affaires étrangères et du Commerce de l’Australie

- DFID

- Department for International Development (UK) / Ministère du Développement international du Royaume-Uni

- EGM

- Europe, Moyen-Orient et Maghreb (secteur de programmes)

- GAR

- La gestion axée sur les résultats

- GAVI

- L’Alliance du Vaccin

- GP

- Gestionnaire de programme

- IPDET

- International Program for Development Evaluation Training

- KFM

- Partenariats pour l'innovation dans le développement (secteur de programmes)

- MAECD

- Ministère des Affaires étrangères, du Commerce et du Développement

- MAECI

- Ministère des Affaires étrangères et du Commerce international

- MFM

- Enjeux mondiaux et développement (secteur de programmes)

- NdE

- Niveau d’effort

- NGM

- Amériques (secteur de programmes)

- OCDE

- Organisation de coopération et de développement économiques

- OECO

- L'Organisation des États des Caraïbes orientales

- OGM

- Asie-Pacifique (secteur de programmes)

- PCE

- Division de l’évaluation du développement (autrefois DED)

- PIGOS

- Programme international en gestion des organismes statistiques

- RCASS

- Renforcement des compétences pour l'amélioration des services à Sulawesi

- S&E

- Suivi et évaluation

- SGEDD

- Système de gestion électronique des documents et des dossiers

- SIG

- Systèmes d’information de gestion

- SMA

- Sous-ministre adjoint

- SMNE

- Santé des mères, des nouveau-nés et des enfants

- UNICEF

- Fonds des Nations unies pour l’enfance

- USE

- Unité des services d’évaluation

- WGM

- Afrique subsaharienne (secteur de programmes)

Sommaire exécutif

Introduction

Le présent rapport rend compte de l’examen des évaluations décentralisées faites entre 2009 et 2014. Durant cette période, les évaluations décentralisées ont été gérées par les secteurs de programmes d’Affaires mondiales Canada (AMC). Elles visaient à favoriser la reddition de comptes, l’apprentissage et la prise de décisions, ainsi qu’à mener à l’amélioration des programmes. Les évaluations décentralisées étaient commandées et gérées au sein des secteurs de programmes, qui en assumaient la responsabilité seule ou conjointement avec d’autres donateurs, et mettaient l’accent sur les projets et les investissements à l’échelon des secteurs.

La finalité de cette étude est de fournir à AMC une évaluation de la qualité des évaluations décentralisées afin d’établir les mesures qu’elle doit prendre pour accroître la crédibilité, la fiabilité, la validité et l’utilisation des évaluations, de même que d’améliorer les systèmes de gestion d’information pour assurer le stockage et le partage des connaissances en matière d’évaluation.

Les six secteurs de programmes de développement d’AMC ont l’entière responsabilité de commander et de mener des évaluations décentralisées. Le rôle de PCE, et surtout de son Unité des services d’évaluation (USE), est de fournir orientation, soutien technique et assurance de la qualité des évaluations décentralisées, en tant que partie intégrante de la fonction de surveillance de PCE. L’USE n’a pas à accepter ni à approuver les résultats attendus de l’évaluation puisque cette responsabilité incombe aux secteurs de programmes.

La portée de l’étude consiste à examiner la planification des évaluations décentralisées, la qualité des documents d’évaluation, soit le cadre de référence, les plans de travail, les rapports d’évaluation et la réponse de la direction, l’efficacité des services de soutien et, enfin, l’utilité des évaluations décentralisées.

Pour évaluer la qualité, nous avons déterminé si les évaluations décentralisées d’AMC respectaient les normes de qualité pour l’évaluation du développement établies par le Comité d’aide au développement (CAD) de l’Organisation de coopération et de développement économiques (OCDE).Note de bas de page 1 Adoptée par 32 donateurs bilatéraux et organismes de développement multilatéraux en 2010, ces normes sont importantes puisqu’elles constituent un cadre international convenu. Axées sur la gestion et le déroulement d’une évaluation, elles visent à renforcer la contribution du travail d’évaluation aux résultats du développement, de même qu’à servir d’étalon par rapport auquel les membres du CAD sont évalués dans le cadre des examens par les pairs du CAD.

L’étude a été entreprise par une équipe d’Itad Ltd, société-conseils du Royaume-Uni, pour le compte de PCE. La méthodologie comportait six éléments : un examen de la qualité des 116 évaluations décentralisées, un sondage en ligne du personnel des secteurs des programmes d’AMC, un examen des services de soutien fournis par PCE, une étude de cas approfondie de huit évaluations décentralisées, un examen des systèmes de gestion de l’information d’AMC et de quatre agences pairs utilisées pour les évaluations, et un examen de l’état des recommandations de la précédente méta-évaluation qui a eu lieu en 2008.

Constatations

Qualité des évaluations décentralisées

Entre 50 % et 60 % des trois principaux documents d’évaluation – cadre de référence, plans de travail et rapports d’évaluation – respectent les normes de qualité du CAD de l’OCDE, mais peu d’entre eux obtiennent une note très satisfaisante.

Certaines indications laissent croire à une amélioration de la qualité au cours de la période d’examen, bien que cette tendance ne soit pas définitive. Le type d’évaluation (formative ou sommative) et le secteur qui mène l’évaluation n’influencent pas vraiment la qualité, mais les projets à budget plus élevé sont mieux évalués. La composition de l’équipe d’évaluation ou la taille du budget d’évaluation n’affectent pas la qualité, mais si le chef d’équipe est aussi évaluateur, la qualité s’en trouve améliorée.

Les documents d’évaluation correspondent à divers degrés aux normes du CAD de l’OCDE. Ils s’en tirent bien en ce qui concerne la plupart des aspects de la planification et de la conduite de l’évaluation, mais ils ne sont pas à la hauteur lorsqu’il s’agit des normes éthiques, de l’évaluabilité et de la méthodologie.

Même si certains aspects des réponses de la direction préparées par les secteurs sont de qualité raisonnable, les aspects liés à la mise en application immédiate des recommandations, au suivi et à la diffusion font piètre figure, comme en témoigne le niveau de détail fourni dans ces rapports.

Des cadres de référence de bonne qualité sont associés à un plan de travail et à un rapport d’évaluation de bonne qualité. Cela signifie qu’il vaut la peine d’investir dans un cadre de référence qui est rédigé avec soin et dans le respect de normes élevées de qualité. On ne constate aucun lien entre la qualité de ces documents et celle de la réponse de la direction, mesurée en fonction du niveau de détail fourni dans ces réponses.

La qualité d’un rapport d’évaluation est plus étroitement liée à quatre critères du CAD de l’OCDE : des questions d’évaluation appropriées, une méthodologie robuste, des constatations logiques et bien attribuées et la clarté de l’analyse. Une analyse plus poussée permet d’affirmer qu’une solide méthodologie est le facteur le plus important pour distinguer les cadres de référence, plans de travail et rapports d’évaluation de bonne qualité de ceux de piètre qualité.

Qualité des processus de planification des évaluations décentralisées

Les évaluations sont généralement planifiées bien à l’avance, mais la présence d’une finalité générale et d’un trop grand nombre de questions d’évaluation complique la tâche aux consultants et à leurs équipes d’évaluation de présenter un rapport de grande qualité. Les gestionnaires de programme des secteurs possèdent divers antécédents professionnels qui peuvent ne pas comprendre l’évaluation, alors que les budgets d’évaluation et les niveaux d’effort sont souvent insuffisants pour répondre aux attentes en matière de portée et de qualité. En outre, l’USE de PCE a de la difficulté à assurer la qualité parce que son mandat est de nature consultative et sa participation ne suffit pas ou n’est pas adaptée pour améliorer le processus de planification et ainsi contribuer à des évaluations de meilleure qualité. L’USE n’adopte pas toujours une approche adaptée à la situation pour évaluer la qualité, ce qui mène à une application inadéquate des normes de qualité. L’effectif de l’USE ne suffit pas non plus à répondre à la demande. L’USE a surtout de la difficulté à donner des conseils en temps opportun.

Utilisation des évaluations décentralisées

Les évaluations décentralisées servent surtout à des fins opérationnelles. Le personnel des secteurs des programmes entreprend de telles évaluations en grande partie pour vérifier le niveau de progression de la mise en œuvre du programme et de l’atteinte de ses objectifs. Les évaluations à mi-mandat servent à améliorer la mise en œuvre, alors que les évaluations finales facilitent la conception d’une nouvelle phase d’un projet ou la décision de prolonger ou non une intervention en cours.

Le personnel des secteurs trouve que les évaluations décentralisées sont plus utiles lorsqu’elles sont faites en temps opportun; et leur utilisation est plus fréquente s’il y a une appropriation, une finalité claire et un intérêt exprimé par la direction. Alors qu’une piètre qualité peut nuire à l’utilisation de l’évaluation, des rapports de bonne qualité ne garantissent pas une diffusion à grande échelle des recommandations et un suivi des plans d’action de la direction.

Les conclusions et les recommandations sont considérées comme les éléments les plus utiles des évaluations. Les leçons sont perçues comme moins utiles, surtout parce qu’il n’existe pas de système de gestion des connaissances à AMC pour favoriser l’apprentissage généralisé au-delà des personnes concernées par l’intervention. En outre, très peu d’évaluations décentralisées sont publiées sur le site Web d’AMC, ce qui en limite encore plus la mise en application et l’utilisation et place AMC en queue de peloton des agences pairs au chapitre de la transparence.

Examen des systèmes de gestion d’information d’AMC

On constate une profonde insatisfaction envers l’approche actuelle d’AMC concernant le stockage et la gestion des évaluations décentralisées, et sa nature ad hoc ne convient pas du tout. L’absence d’un système centralisé pour stocker les évaluations décentralisées leur enlève leur utilité pour l’organisation dans son ensemble. Les difficultés auxquelles AMC se bute ne sont pas uniques. Les autres agences ont opté soit de faire le suivi des évaluations en les publiant sur leur site Web ou en mettant en place une base de données consacrée aux évaluations afin d’offrir une meilleure façon de les stocker, de les récupérer et de les consulter. Cette dernière solution nécessite d’investir au-delà du matériel informatique, mais aussi dans des incitatifs pour susciter l’utilisation du système. À titre de comparaison, deux agences des Nations Unies encouragent le téléchargement et l’utilisation des évaluations en leur attribuant une note de qualité, en faisant le suivi des évaluations planifiées et publiées, ainsi qu’en reconnaissant les meilleures évaluations chaque année.

Mise en œuvre des recommandations de la méta-évaluation de 2008

Le rapport de 2008 recommande de renforcer PCE et de clarifier sa fonction et ses responsabilités dans le cadre du travail d’évaluation décentralisée. Depuis, après l’intégration de l’Agence canadienne de développement international (ACDI) au ministère des Affaires étrangères, du Commerce et du Développement (MAECD), aucun renforcement important de l’effectif n’a eu lieu; les postes nécessaires n’ont pas été dotés au cours de la période d’examen, et le roulement du personnel a été considérable. La politique d’évaluation du Ministère de 2005 n’a pas été mise à jour, et même si la Politique du Conseil du Trésor sur l’évaluation de 2009 précise les exigences relatives à la fonction d’évaluation dans l’ensemble du gouvernement, son application aux évaluations décentralisées n’y est pas explicitement abordée. On a fait très peu d’avancées concernant les recommandations de l’étude de 2008 portant sur la formation, la gestion de l’information et la communication.

Conclusions

L’étude conclut que le cadre de la politique d’évaluation ministérielle publié en 2005, même s’il était un solide document à l’époque, ne tient pas compte des changements apportés aux normes et pratiques internationales en matière d’évaluation, comme l’introduction des normes du CAD de l’OCDE en 2009, ni des importants changements survenus dans le contexte institutionnel du gouvernement du Canada en matière d’aide au développement, comme la fusion de l’ACDI et du MAECI, ainsi que les nouvelles politiques du Conseil du Trésor en matière d’évaluation. Le rôle et le statut de PCE n’ont pas été renforcés pour lui permettre de jouer son rôle de veiller à ce que l’efficacité de l’aide au développement soit rigoureusement mesurée.

Entre 50 % et 60 % des documents d’évaluation décentralisée sont de qualité acceptable, mais très peu d’entre eux obtiennent une note très satisfaisante. Au cours de la période allant de 2009 à 2014, plus de 40 % des projets examinés par l’équipe d’étude (représentant des dépenses de programme de 2,8 milliards de dollars)Note de bas de page 2 n’ont pas été bien évalués et, par conséquent, leurs résultats et rendement n’ont pas fait l’objet d’une évaluation fiable.

Le rôle de PCE dans le soutien de la qualité des évaluations décentralisées demeure flou. L’USE ne dispose pas de ressources suffisantes pour remplir le rôle attendu d’elle. Même si les utilisateurs de ses services les jugent utiles, son travail d’amélioration de la qualité n’est pas aussi efficace qu’il pourrait l’être. La fonction d’assurance de la qualité de l’USE semble être facultative puisque le personnel des secteurs ne requiert pas toujours ses services et contournent ses processus. En outre, on ne sait pas trop qui a le dernier mot sur la qualité et l’approbation de ces évaluations.

Les outils et modèles de qualité offerts par l’USE sont généralement utiles, de l’avis de leurs utilisateurs, mais ils ne règlent pas la question des capacités généralement faibles du personnel des secteurs. La stratégie de soutien adoptée par l’USE ne permet pas de trouver un équilibre entre la nécessité, d’une part, d’avoir des évaluations décentralisées de meilleure qualité et, d’autre part, d’offrir des évaluations à l’échelon des secteurs qui sont menées plus rapidement et plus faciles à utiliser.

Le système toujours utilisé par l’USE pour faire le suivi des évaluations décentralisées, les stocker et en tirer des apprentissages n’est pas efficace. Il est difficile de récupérer les documents et impossible de regrouper les constatations et les leçons.

Durant la période d’examen, on percevait que les évaluations décentralisées avaient moins de prestige et d’attention que les évaluations ministérielles, même si elles représentaient la majeure partie des dépenses en évaluation. L’ensemble des connaissances générées est imposant et aurait pu être utilisé plus efficacement pour éclairer AMC, le gouvernement du Canada, la population canadienne et le public international.

Recommandations

Le système d’évaluation décentralisée en place au sein d’AMC vise à fournir une orientation opérationnelle à chaque projet et une source d’apprentissage pour toute l’organisation. Il est possible d’améliorer davantage la qualité de ces évaluations et d'en soutenir plus fortement et efficacement la planification, la mise en œuvre, le stockage et l'utilisation. C’est pourquoi la présente étude fait les recommandations suivantes.

- Renforcement du soutien aux évaluations décentralisées.

- Renforcer le rôle de la personne-ressource de l’évaluation au sein des secteurs en leur donnant une responsabilité claire et un encadrement afin de favoriser l’échange des connaissances en matière d’évaluation au sein de leur secteur.

- Clarifier les rôles et les responsabilités de tous les intervenants (personnel des secteurs, USE, cadres supérieurs, Comité de l’évaluation du développement, etc.), pour veiller à ce que l’amélioration de la qualité des évaluations soit convenablement soutenue (c’est-à-dire qu’elle soit intégrée et complète), ce qui est reflété (et communiqué) dans une politique d’évaluation révisée.

- Donner plus de formation et renforcer les compétences en évaluation du personnel des secteurs et envisager de faire travailler par rotation le personnel ayant des compétences en évaluation aux bureaux de la région ou du pays, surtout dans les pays ciblés par AMC.

- Donner un soutien adéquat à PCE/USE, soit du personnel en évaluation et des ressources budgétaires appropriés.

- Renforcement de l’échange et de l’utilisation des évaluations.

- Présenter, en guise de point permanent à l’ordre du jour du Comité d’évaluation du développement, une déclaration périodique sur le nombre et l’état des évaluations décentralisées planifiées, commandées et achevées par secteur, thème et budget.

- Élaborer une stratégie de gestion des connaissances détaillée qui prévoit un forum pour échanger les leçons tirées des évaluations décentralisées, ainsi que la publication des rapports d’évaluation décentralisée, conformément à ce qui se fait sur la scène internationale.

- Instaurer une culture plus favorable à l’échange et à l’utilisation des connaissances tirées des évaluations par une meilleure communication et l’utilisation de divers médias (Web, médias sociaux, réseaux), ainsi que récompenser et reconnaître les bonnes pratiques et la qualité. Travailler dans le but de publier l’ensemble des évaluations achevées à moyen terme.

- Renforcement de la planification et de la conduite des évaluations décentralisées.

- Renforcer le rôle, les capacités et les ressources du travail d’évaluation décentralisée à l’échelon des secteurs. Pour ce faire, élaborer et mettre en œuvre une stratégie de formation afin de permettre aux secteurs d’acquérir des compétences de base en évaluation et de travailler à partir de directives plus pratiques.

- Renforcer le rôle de l’USE en tant que courtier du savoir et non de l’assurance de la qualité.Note de bas de page 3 Pour ce faire, envisager que l’USE se concentre sur l’élaboration de directives et outils appropriés pour les évaluations décentralisées, en travaillant plus étroitement avec les secteurs sur certaines évaluations, et en concevant de meilleurs systèmes de gestion des connaissances. Renforcer les capacités de l’USE en dotant l’unité d’un effectif possédant le bon ensemble de compétences et d’expériences en évaluation, ainsi qu’une connaissance et une expertise de l’organisation et du contexte.

- Veiller à ce que les secteurs planifient annuellement les évaluations décentralisées à mener à l’aide des outils et du personnel de l’USE.

- Renforcement de la gestion de l’information des évaluations décentralisées.

- À court et à moyen terme, renforcer l’accessibilité aux évaluations décentralisées. Par exemple, PCE pourrait tenir à jour une liste consolidée sur l’intranet et concevoir une fonction qui permet de mettre le personnel au courant des évaluations terminées, de la réponse de la direction et des principales constatations. Explorer la possibilité d’utiliser les bases de données existantes (p. ex. CRAFT) à cette fin.

- À long terme, créer une plateforme pour permettre au personnel et aux intervenants externes d’accéder à toutes les évaluations décentralisées.

Réponse de la direction

Aperçu

La Méta-évaluation des évaluations décentralisées d’Affaires mondiales Canada pour la période de 2009 à 2014 a été effectuée par Itad Ltd, société-conseil du Royaume-Uni, pour le compte de PCE (Direction de l’évaluation du développement). Elle visait à fournir à AMC une évaluation de la qualité des évaluations décentralisées afin d’établir les mesures qu’elle doit prendre pour accroître la crédibilité, la fiabilité, la validité et l’utilisation des évaluations, de même que d’améliorer les systèmes de gestion d’information pour assurer le stockage et le partage des connaissances en matière d’évaluation.

Selon les constatations et les conclusions, ainsi que pour soutenir l’amélioration de la planification, de la qualité et de l’utilisation des évaluations décentralisées, le rapport recommande de renforcer quatre aspects : 1) le soutien accordé aux évaluations décentralisées; 2) la diffusion et l’utilisation des évaluations décentralisées; 3) la planification et la conduite des évaluations décentralisées, et 4) la gestion de l’information issue des évaluations décentralisées. Sur les douze recommandations formulées dans le rapport, toutes sont acceptées.

La Direction de l’évaluation du développement d’Affaires mondiales Canada prend note des lacunes de rendement cernées par les évaluateurs dans le cadre de la méta-évaluation. Bon nombre de ces lacunes ont mis en lumière la nécessité de renouveler les processus et de mettre à jour les outils pour soutenir l’amélioration de la qualité et de l’utilisation des évaluations décentralisées menées par les secteurs de programmes de développement d’AMC. La direction de PCE accueille ces recommandations comme une occasion de réviser et d’améliorer les ressources et le rôle de l’Unité des services d’évaluation de PCE pour offrir de l’orientation au personnel des secteurs tout au long du cycle de vie de la planification des évaluations décentralisées, ainsi que pour veiller à ce qu’un soutien adéquat soit offert pour répondre à la demande. PCE reconnaît également la nécessité de mettre à profit les ressources d’AMC sur plusieurs plans, notamment : apprentissage et formation; communications; développement et transfert des connaissances; résultats et exécution; gestion des données et de l’information, et mesure du rendement.

Les recommandations formulées dans le cadre de cette évaluation insufflent à la direction des secteurs un nouveau souffle afin de mettre à jour les processus et de tirer profit des plateformes existantes pour combler les lacunes persistantes qui ont actuellement une incidence sur la planification, la qualité et l’utilisation d’une grande portion des documents d’évaluation décentralisée. Comme en témoignant les engagements et les mesures de suivi proposés dans le tableau ci-dessous, PCE s’attaquera à certains aspects en vue de renforcer les processus liés aux évaluations décentralisées et leur diffusion; la collaboration des secteurs énumérés sera également essentielle pour superviser et faire le suivi de la mise en œuvre de cette réponse de la direction.

| Recommandations | Engagements | Mesures | Centre de responsabilité4 | Date d’achèvement prévue |

|---|---|---|---|---|

| 4 Le terme « responsable » désigne ici le groupe chargé de mettre en œuvre des mesures précises. Sous « consultation » figurent les noms des groupes qui seront appelés à formuler leurs commentaires. | ||||

| 1. (i) Renforcer le rôle des points de liaison des secteurs en leur attribuant des responsabilités et des obligations de rendre compte qui sont clairement définies afin de promouvoir la mise en commun des connaissances en matière d’évaluation au sein des secteurs. | Accepté : a) PCE dirigera la mise à jour de la politique d’évaluation du développement d’AMC (en consultation avec ZIE et d’autres intervenants compétents) et obtiendra une approbation. | PCE rédigera une mise à jour de la politique d’évaluation du développement d’AMC qui définira les rôles, les responsabilités et les secteurs de responsabilité des principaux intervenants ainsi que du chef de l’évaluation. La nouvelle politique tiendra compte de la responsabilité du chef de l’évaluation du développement quant à l’approbation des cadres de référence des évaluations décentralisées ainsi que des rapports d’évaluation finaux. L’élaboration de la politique comprendra des consultations avec les principaux intervenants à l’ensemble du Ministère et l’harmonisation avec la nouvelle politique sur les résultats du CT, le cadre des résultats du Ministère, les engagements du gouvernement du Canada à l’égard d’un gouvernement ouvert ainsi qu’avec d’autres directives liées à la GAR. PCE présentera la mise à jour de la politique au Comité d’évaluation du développement (CED) pour examen et recommandation d’approbation du président du CED. PCE élaborera des lignes directrices, des directives et des outils d’appui, au besoin, afin d’aider le Ministère à mettre en œuvre la politique mis à jour. | Responsable : PCE Consultation : PCC, DDR, ZIE, DEC | Présentation au CED d’ici janvier 2018 Mars 2018 |

| Accepté : b) Les secteurs (WGM, EGM, NGM, OGM, KFM et MFM) désigneront leurs points de contact et s’assureront qu’ils possèdent les attributions/ressources suffisantes pour s’acquitter de leurs responsabilités. (On s’attend à ce que les secteurs tirent parti de l’expertise existante, par exemple des membres du Groupe de travail ministériel de l’évaluation et des membres du Réseau des conseillers en mesure du rendement pour ces tâches – il pourrait s’avérer nécessaire de modifier les exigences liées à la charge de travail ou au poste, selon l’évaluation de la charge de travail réelle, compte tenu des tâches supplémentaires). | PCE collaborera avec PCC afin de cibler les occasions de collaboration en réunissant les points de contact GAR des secteurs et les rôles des points de contact en matière d’évaluation. Les secteurs désigneront les points de contact chargés de coordonner la planification des évaluations et de les représenter concernant les tâches liées à l’évaluation. Il faudra au moins inclure les responsabilités dans les ententes de gestion du rendement et les indiquer dans monÉquipe. Les secteurs seront aussi tenus d’élaborer un plan annuel des évaluations décentralisées pour l’année à venir. Le plan sera soumis à PCE aux fins d’approbation et intégré au plan d’évaluation quinquennal ministériel. Les secteurs évalueront la charge de travail nécessaire à l’exécution des activités de leurs points de contact et attribueront les ressources en conséquence. Les secteurs s’assureront de prévoir dans le plan d’évaluation de leurs points de contact au moins trois journées complètes de formation par année portant sur des tâches liées à l’évaluation. PCE apportera son soutien concernant la formation et l’élaboration d’un plan d’apprentissage des points de contact en matière d’évaluation. | Responsables : WGM, EGM, NGM, OGM, KFM, MFM Collaboration : PCE, PCC | Avril 2017 Avril 2017 Avril 2017 Avril 2017 | |

| Accepté : c) PCE proposera une plateforme (technologique ou autre) pour la liaison avec les points de contact des secteurs. | PCE rencontrera régulièrement les points de contact des secteurs (en misant sur les comités existants comme le Groupe de travail sur l’évaluation (GTE) ou le Réseau des conseillers en gestion du rendement (RCGR). PCE cernera les plateformes existantes, technologiques ou autres, qui permettront le partage des tâches liées à l’évaluation parmi les points de contact des secteurs. | Responsable : PCE Collaboration : RCGC de PCC | Réunion initiale : mai 2017 Juillet 2017 | |

| (ii) Préciser les rôles et les responsabilités de chacun des intervenants (personnel des secteurs, USE, haute direction, Comité d’évaluation du développement, etc.) et s’assurer qu’il y a un soutien suffisant pour améliorer la qualité des évaluations (intégrées et complètes) et que cela est pris en compte (et communiqué) dans une politique d’évaluation mis à jour. | Accepté : On donnera suite à la recommandation 1.ii visée par les engagements et les mesures précisés au point 1.i. | |||

| (iii) Accroître la formation en matière d’évaluation pour le personnel des secteurs et envisager la permutation du personnel possédant des compétences en évaluation dans les bureaux d’autres régions/pays, particulièrement les pays ciblés par Affaires mondiales Canada. | Accepté : a) PCE mettra en œuvre une Stratégie d’apprentissage horizontal pour les évaluations du développement | Créer des séances et des documents de formation initiale selon la Stratégie d’apprentissage horizontal (SAH). PCE collaborera avec le CFSI et PCC pour élaborer un programme de formation sur l’évaluation ou s’assurer qu’il s’inscrit dans les programmes de formation existants (par exemple la formation de trois jours sur la GAR et la séance de formation sur le PPA). Étudier les possibilités d’offrir une formation sous forme d’atelier s’adressant aux agents de projet amorçant une évaluation. Élaborer de nouveaux outils et de nouveaux modèles, et les publier sur Modus (au moins deux par année). Cerner les possibilités d’apprentissage initiales pour les points de contact des secteurs en tant que point à l’ordre du jour des rencontres régulières. | Responsable : PCE Collaboration : CFSI, PCC | Avril 2017 Juin 2017 Avril 2017 Octobre 2017 Avril 2017 |

| (iv) S’assurer que PCE/l’USE disposent des ressources budgétaires adéquates et d’experts en évaluation. | Accepté : a) PCE veillera à ce que tous les postes de l’Unité de services en évaluation (USE) soient comblés. | Les postes existants à PCE seront comblés. Dans le respect des limites budgétaires, les ressources seront réaffectées à l’USE, au besoin. On fera le suivi de la charge de travail et on l’évaluera durant six mois afin d’estimer de façon plus précise les besoins en matière du travail. | Responsable : PCE | Février 2017 Février 2017 Août 2017 |

| 2. (i) Présenter au Comité d’évaluation du développement, inscrire un point permanent à l’ordre du jour et faire le point régulièrement sur les évaluations décentralisées planifiées, commandées et terminées pour chaque secteur, ainsi que sur l’objet et le budget de ces évaluations une déclaration. | Accepté : a) Veiller à ce que le Comité d’évaluation du développement (CED) soit au courant de l’état des évaluations décentralisées et puisse faire des commentaires à ce propos. | Un rapport initial sur l’état des évaluations décentralisées suivant la mise en œuvre de la nouvelle politique d’évaluation sera présenté au CED. On s’attend à ce que ce dernier fasse des recommandations en fonction de ce rapport d’étape, lequel sera ajouté comme point permanent à l’ordre du jour des réunions du CED. Évaluer la disponibilité des données à inclure dans les rapports d’étape. Il convient de noter que ceux-ci seront produits par l’USE en fonction des données disponibles au moment où les rapports sont exigés. L’information sur les plans des secteurs sera incluse annuellement dans les rapports d’étape à mesure qu’elle est disponible. | Responsable : PCE Collaboration : PCR, SID, PCC, SGCP | Rapport initial : Janvier 2017 Avril 2017 |

| (ii) Élaborer une stratégie détaillée de gestion de l’information prévoyant la mise en commun les leçons retenues des évaluations décentralisées, et la publication de rapports sur les évaluations décentralisées conformes aux pratiques internationales. | Accepté : a) Veiller à ce que les rapports sur les évaluations décentralisées soient accessibles à tous les intervenants internes et externes | S’assurer de la publication des sommaires d’évaluation sur le site Web d’AMC, ainsi que des rapports complets sur certaines évaluations, selon les engagements pris dans le calendrier de mise en œuvre de l’ITTA d’AMC. Lier les lignes directrices et les outils en matière d’évaluation aux processus et aux directives existants (GAR, PPA) ainsi que les travaux menés par SII concernant une feuille de route sur la gestion des connaissances. Améliorer les outils et les mécanismes existants afin de suivre et de stocker les métadonnées sur les évaluations décentralisées. Cela peut inclure tirer parti d’InterData, de GCDocs ou d’autres bases de données pouvant découler des exigences de la mise en œuvre de la Politique sur les résultats. | Responsable : PCE Collaboration : LOD, PCR, PCC, SGGP, SII, PVD | Décembre 2017 Août 2017 Août 2018 |

| (iii) Créer une culture plus solide favorisant la mise en commun et l’utilisation des connaissances sur les évaluations au moyen d’une meilleure communication et de l’utilisation de divers médias (Web, médias sociaux, réseaux), et permettant de récompenser et de reconnaître les bonnes pratiques et les pratiques de haute qualité. Viser à moyen terme la publication de toutes les évaluations terminées. | Accepté : a) PCE collaborera avec PVA et d’autres intervenants compétents à l’élaboration d’une stratégie commune afin de faciliter l’élaboration, la mise en commun et l’utilisation des connaissances en matière d’évaluation. Accepté : b) PCE collaborera aussi avec LOD pour veiller à ce que la stratégie respecte les normes ministérielles. | Étudier les possibilités de tirer parti des évaluations décentralisées existantes en mettant à l’essai des analyses de données non structurées en collaboration avec PCR. Utiliser les mécanismes et les produits existants et nouveaux de mise en commun des connaissances (p. ex. la page Au Courant, les messages pour diffusion générale, la participation à des comités de gestion du savoir, etc.) afin de transmettre les nouvelles connaissances provenant des évaluations décentralisées de manière plus efficace et dans un format répondant aux besoins des clients et adapté aux contraintes, en collaboration avec PVA/LOD. À long terme, élaborer des directives et en assurer la mise en œuvre pour la diffusion des évaluations et des résultats aux partenaires et aux intervenants. | Responsable : PCE Collaboration : PVA, LOD, PCR | Mars 2017 Stratégie initiale : juillet 2017 |

| Accepté : c) Reconnaître et encourager les évaluations de qualité | PCE proposera des mesures de reconnaissance ou incitatives pour favoriser l’amélioration de la qualité des évaluations décentralisées | Responsable : PCE | Février 2018 | |

| 3. (i) Renforcer le rôle, les capacités et les ressources pour les évaluations décentralisées au niveau des secteurs. Atteindre cet objectif en élaborant une stratégie de formation et en la mettant en œuvre afin de fournir aux secteurs des compétences de base en évaluation et des directives plus pratiques. | Accepté : La recommandation 3.i sera visée par les engagements et les mesures précisés au point 1.iii. | |||

| (ii) Renforcer le rôle de l’USE à titre de courtier du savoir relatif à l’évaluation du développement plutôt que de mettre l’accent sur l’assurance de la qualité. Pour atteindre cet objectif, envisager d’axer le travail de l’USE sur l’élaboration de directives et d’outils, le travail en étroite collaboration avec les secteurs pour certaines évaluations, et la création de meilleurs systèmes de gestion des connaissances. Renforcer la capacité de l’USE en lui fournissant la bonne combinaison de compétences et d’expérience en évaluation, et de connaissances et d’expertise organisationnelle/contextuelle. | Accepté : Différents engagements énoncés ci dessus répondront à ce besoin. | |||

| (iii) Veiller à ce que les secteurs planifient les évaluations décentralisées chaque année conformément aux directives de l’USE et de son personnel. | Accepté : a) Conseiller les secteurs (WGM, EGM, NGM, OGM, KFM et MFM) dans l’élaboration de plans d’évaluation qui s’échelonnent sur une période de cinq ans (mise à jour annuelle). | Les points de contact des secteurs tireront parti de l’outil de planification axée sur les risques élaboré par PCE aux fins de planification des évaluations. Les secteurs devront élaborer pour l’année à venir un plan annuel des évaluations décentralisées qui contient de l’information sur le calendrier, la portée et le budget associés à chacune des évaluations. Le plan sera remis à PCE aux fins d’approbation et intégré dans le plan d’évaluation quinquennal du Ministère. Les SMA des secteurs auront des engagements énoncés dans les plans d’évaluation des secteurs qu’il faudra inclure dans leur entente de gestion du rendement. | Responsable : Points de contact des secteurs (et autres représentants des secteurs, au besoin) Collaboration : PCE | Plan initial : novembre 2017 |

4. (i) À court ou moyen terme, accroître l’accessibilité des évaluations décentralisées. Par exemple, PCE pourrait établir une liste consolidée sur l’intranet et créer une fonction qui permettrait d’informer le personnel sur les évaluations terminées, les réponses de la direction et les principales constatations. Envisager le recours aux bases de données existantes à cette fin. (ii) À long terme, créer une plateforme permettant au personnel et aux intervenants externes d’avoir accès à toutes les évaluations décentralisées. | Accepté : a) Selon les décisions ministérielles et l’évolution des bases de données et structures de saisie de renseignements et de données, PCE collaborera avec les parties prenantes pour planifier une stratégie de stockage des produits et mégadonnées liés aux évaluations décentralisées, et veillera à ce qu’il soit possible de faire des recherches dans ces produits et les renseignements qu’ils contiennent. | Tenir à jour un tableur Excel sur les produits d’évaluation décentralisée actuels, y compris les mégadonnées, en vue de leur intégration à une plateforme technologique. On tirera parti des actions et de la collaboration dont il est question aux recommandations 2 (ii) et 2 (iii) pour répondre à ce besoin. | Responsable : PCE Responsable : PCE | Version initiale : Janvier 2017 Plan initial : Octobre 2018 |

1 Introduction

Le présent rapport constitue le tout dernier livrable de la méta-évaluationNote de bas de page 5 menée pour Affaires mondiales Canada (AMC).Note de bas de page 6 Il porte surtout sur la qualité et l’utilisation des évaluations décentralisées.Note de bas de page 7 Pour évaluer la qualité, nous avons déterminé si les évaluations décentralisées d’AMC respectaient les normes de qualité pour l’évaluation du développement établies par le Comité d’aide au développement (CAD) de l’Organisation de coopération et de développement économiques (OCDE).Note de bas de page 8 Adoptée par 32 donateurs bilatéraux et organismes de développement multilatéraux en 2010, ces normes sont importantes puisqu’elles constituent un cadre international convenu. Axées sur la gestion et le déroulement d’une évaluation, elles visent à renforcer la contribution du travail d’évaluation aux résultats du développement, de même qu’à servir d’étalon par rapport auquel les membres du CAD sont évalués dans le cadre des examens par les pairs du CAD.

L’étude s’est échelonnée d’octobre 2015 à septembre 2016; l’étape de démarrage s’est déroulée d’octobre à décembre 2015, puis la collecte de données a été effectuée de janvier à juin 2016. Elle a été entreprise par une équipe de cinq personnes d’Itad Ltd, cabinet-conseil du Royaume-Uni.

Ce rapport final comporte huit sections : introduction (section 1), objectifs et portée (section 2), évaluation de l’évaluabilité (section 3), méthodologie (section 4), constatations (section 5), ainsi que conclusions, leçons et recommandations (sections 6, 7 et 8).

1.1 Évaluations décentralisées à Affaires mondiales Canada

Les évaluations décentralisées sont des évaluations commandées et gérées par les secteurs de programmesNote de bas de page 9 afin de faciliter la reddition de comptes, l’apprentissage et la prise de décisions, ainsi que d’améliorer la programmation. Elles sont menées par des évaluateurs ou des firmes d’évaluation du secteur privé qui reçoivent le mandat par l’entremise des mécanismes d’approvisionnement du gouvernement du Canada. La décision de mener une évaluation décentralisée, tout comme sa portée, sa structure et les questions précises à aborder, repose sur les besoins et exigences des gestionnaires au sein des secteurs de programmes et ceux des partenaires de projet ou de programme. Les secteurs de programmes sont entièrement responsables de commander, de mener et d’assurer l’utilisation des évaluations décentralisées.

Les évaluations décentralisées servent également d’éléments constitutifs aux évaluations ministérielles qui sont menées au sein du Secteur des politiques, car elles sont une excellente source de données, surtout pour évaluer l’efficacité des programmes. Elles diffèrent des évaluations ministérielles lesquelles abordent de plus vastes questions thématiques et sont commandées et gérées directement par la Direction de l’évaluation du développement, ou PCE (autrefois appelées DED) d’AMC.

Le rôle de PCE dans le cadre des évaluations décentralisées est d’en assurer la qualité. Plus précisément, pendant toute la durée de l’évaluation, l’Unité des services d’évaluation (USE) de PCE voit à fournir orientation, soutien technique et assurance de la qualité des évaluations décentralisées, en tant que partie intégrante de la fonction de surveillance de PCE. L’USE est une petite équipe qui examine les livrables de l’évaluation, notamment le cadre de référence, les plans de travail et les rapports d’évaluation. Sa contribution est offerte au besoin, selon les demandes présentées par les secteurs de programmes. L’Unité a établi des modèles de rapports et des normes de qualité, en fonction des principes du CAD de l’OCDE, à l’intention des personnes responsables de commander et de rédiger les évaluations décentralisées. À l’exception du cadre de référence, qu’elle doit approuver avant qu’un appel d’offres ne soit enclenché, l’USE n’a pas l’autorité d’accepter ni d’approuver les livrables de ce type d’évaluation puisque cette responsabilité incombe aux secteurs de programmes. L’USE ne voit pas non plus à évaluer les soumissions des consultants souhaitant mener l’évaluation.

2 Objectifs et portée

2.1 Finalité

La présente méta-évaluation des évaluations décentralisées a comme finalité de fournir à AMC :

- une évaluation de la qualité des évaluations décentralisées;

- un ensemble de mesures à prendre par PCE pour améliorer la qualité des outils, principes directeurs et processus de planification d’AMC et ainsi accroître la crédibilité, la fiabilité, la validité et l’utilisation des évaluations;

- des recommandations pour améliorer les systèmes d’information de gestion (SIG) qui facilitent le stockage et le partage des connaissances en matière d’évaluation.

La présente méta-évaluation servira à PCE et aux secteurs de programmes.

La finalité qui sous-tend la conduite de cette évaluation se fonde sur l’un des rôles confiés à PCE. En effet, conformément à la Politique d’évaluation du développement (ACDI, 2005), PCE est chargé de rendre compte de la qualité des évaluations décentralisées au comité d’évaluation en procédant périodiquement à des contrôles de la qualité et à des méta-évaluations.Note de bas de page 10

Une méta-évaluation a déjà été menée en 2008.Note de bas de page 11 L’examen de ses recommandations vient également justifier la nécessité de la présente étude.

Depuis 2008, il existe de nouvelles normes de qualité (fondées sur les normes de qualité pour l’évaluation du développement du CAD),Note de bas de page 12 et celles-ci ont été officiellement intégrées aux accords d’offre à commandes établies pour le Ministère en 2009 afin d’obtenir des services d’évaluation. Elles fournissent dorénavant un tout nouveau cadre pour évaluer la qualité des évaluations.

La présente étude nous donne une belle occasion d’examiner l’évolution des évaluations décentralisées d’AMC au cours des sept dernières années, puis de déterminer si elles correspondent bien aux principes directeurs du CAD, s’il existe des obstacles à leur qualité et s’il y a des façons pour PCE de resserrer son appui aux secteurs de programmes à ce chapitre.

Enfin, avec la création d’Affaires mondiales Canada (autrefois le MAECD) par la fusion de l’ACDI et du MAECI, la période à l’étude a vu d’importants changements organisationnels et roulement du personnel par rapport à l’époque précédant la fusion. L’intégration des fonctions des affaires étrangères et du commerce à celle de l’aide au développement, ainsi que le transfert de la responsabilité d’évaluation à un ministère chargé de l’établissement de politiques, a créé un terrain fertile pour les synergies, mais a également nécessité le recadrage du travail de développement au sein de cette nouvelle structure. Les incitatifs ont changé, et un accent plus marqué est dorénavant mis sur l’étude minutieuse et la valeur ajoutée de l’aide depuis l’adoption de la Loi fédérale sur la responsabilité. En 2015, l’avènement d’un nouveau gouvernement au Canada est également venu insuffler une nouvelle orientation stratégique à l’aide fournie, ainsi qu’à la mesure et à la responsabilité de ses résultats, et les répercussions de ce changement sur l’évaluation ne se sont pas encore fait pleinement sentir.

2.2 Objectifs spécifiques

Selon le cadre de référence, la méta-évaluation doit viser huit objectifs particuliers :

- Évaluer la qualité des évaluations décentralisées en fonction des normes de qualité pour l’évaluation du développement du CAD de l’OCDE;

- cerner les éléments ou les critères de qualité qui sont parfaitement respectés ou qui laissent à désirer dans les documents d’évaluation d’AMC;

- examiner les forces et les faiblesses des processus de planification des évaluations décentralisées;

- déterminer si le soutien et l’expertise, ainsi que les outils de PCE, ont été mis à contribution dans les évaluations décentralisées;

- établir si les constatations, les conclusions, les recommandations et les leçons issues des évaluations décentralisées ont été utilisées et à quelles fins, ou, si elles n’ont pas été utilisées, déterminer pourquoi;

- déterminer la mesure dans laquelle les recommandations issues de la méta-évaluation de l’ACDI en 2008 ont été appliquées;

- examiner les SIG utilisés actuellement pour le stockage et le partage des évaluations décentralisées et se pencher sur les améliorations ou les mises à niveau possibles de ces systèmes;

- recommander des mesures à prendre pour améliorer la qualité des évaluations.

2.3 Objet et portée de l’évaluation

Le cadre de référence précise quatre objets pour cette méta-évaluation. Ensemble, ces quatre objets servent de fondement à l’évaluation de tout le cycle de vie des évaluations décentralisées, de leur planification à leur éventuelle utilisation. Ils sont présentés au Tableau 1.

| Objet de l’évaluation | Portée |

|---|---|

| 13 Rapport d’inventaire des évaluations décentralisées – Sommaire, AMC, le 14 octobre 2015. 14 Cousins, B. et K. Leithwood. « Current empirical research on evaluation utilization », Review of Educational Research, vol. 56, 1986. | |

| 1. Le processus d’évaluation | Toutes les étapes à suivre en moment d’élaborer une évaluation décentralisée, du respect des politiques et procédures d’AMC déterminant la nature, le moment et la quantité d’évaluations à mener, jusqu’à la prise de mesures administratives pour commander, budgéter et enclencher une évaluation. |

| 2. La qualité des documents d’évaluation au début et à la fin | Toutes les évaluations décentralisées menées par les six secteurs d’AMC entre le 1er avril 2009 et le 31 mars 2014. Selon l’inventaire de PCE, il existe 1 124 documents liés à 467 projets.13 Seuls les projets de plus de 2 millions de dollars sont pris en considération. La valeur totale du décaissement nécessité par ces projets est de 6,93 milliards de dollars. Les évaluations couvrent quatre types de livrables : un cadre de référence, un plan de travail, un rapport d’évaluation et une réponse de la direction. Il existe trois principales catégories d’évaluation : formative, sommative et autre. La voie empruntée pour mener l’évaluation n’est pas toujours la même : certaines évaluations sont gérées par AMC dans le cadre d’offres à commandes (maintenant expirées) et certaines sont gérées par les secteurs de programmes sur le terrain, alors que d’autres sont gérées conjointement avec des partenaires du développement en ayant recours aux mécanismes d’approvisionnement de ces derniers. |

| 3. Les services et outils de PCE | Les capacités, systèmes et outils de PCE pour appuyer les évaluations décentralisées, en mettant l’accent sur l’USE. Cela comprend :

|

| 4. L’utilité des évaluations et des processus | Le degré d’utilisation d’un échantillon de rapports d’évaluation par divers intervenants, ainsi que le caractère adéquat des SIG d’AMC pour stocker et partager tous les livrables des évaluations de façon que les utilisateurs trouvent utile. Les évaluations servent à trois utilisations :

|

Compte tenu de la nature différente de ces quatre objets, l’équipe responsable de l’étude a conçu des méthodologies et outils distincts pour chacun. Ces méthodologies et outils sont décrits au chapitre 4. L’utilité d’une évaluation ne découle pas seulement de sa qualité, elle dépend aussi du cadre institutionnel et des incitatifs. La portée de la présente méta-évaluation comprend donc une évaluation de ces facteurs.

Intervenants : Dans le cadre de sa portée, l’étude reconnaît la nécessité d’inclure divers groupes d’intervenants. Ceux-ci sont bien définis dans le cadre de référence et on en compte trois principaux : les commanditaires des évaluations décentralisées, les exécutants des évaluations décentralisées et les utilisateurs de cette méta-évaluation. Le plan de travail précise les moyens que prendra l’équipe d’étude pour joindre ces divers acteurs.Note de bas de page 15

3 Évaluabilité

Le plan de travail permet de souligner les obstacles possibles au processus d’évaluation et à sa conception et cherche à les atténuer. L’approche de l’étude, présentée en détail dans le plan de travail, tente d’aborder les limites de la méthodologie, les contraintes pratiques et logistiques auxquelles l’équipe peut se buter, la disponibilité des données et des gens, ainsi que tout conflit d’intérêts découlant des expériences antérieures de notre équipe. L’expérience acquise lors de la précédente méta-évaluation menée en 2008 a également servi à élaborer le plan de travail. Par exemple, lors de l’étude de 2008, nous avons eu beaucoup de difficultés à repérer avec précision et à récupérer les documents d’évaluation. Pour surmonter cet obstacle, PCE a consacré plus d’un an à dresser l’inventaire des livrables des évaluations en vue de la présente étude. L’équipe d’étude a ensuite choisi une méthode d’échantillonnage dirigé afin d’obtenir la couverture la plus représentative possible des documents inventoriés et de remplacer les cas pour lesquels la documentation était incomplète. La stratégie de collecte de données a été conçue pour permettre à l’équipe de joindre les intervenants clés par divers moyens. Ainsi, pour éviter un éventuel manque de données probantes, la méthodologie prévoyait la consultation de plusieurs sources de données pour combler les lacunes et en arriver à des constatations plus solides.

Pour éviter de compromettre l’indépendance de l’évaluation, Itad a également examiné le lien qui unit ou unissait chacun des membres de l’équipe à l’ACDI et à AMC, puis a éliminé toute possibilité de conflit d’intérêts, notamment lorsque des membres de l’équipe avaient pris part à des évaluations antérieures. Les données tirées des entrevues et des documents consultés ont été conservées dans un endroit sûr et confidentiel.

4 Méthodologie

4.1 Questions d’évaluation

Le cadre de référence comporte six grandes questions d’évaluation. Ces questions portent sur : i) la qualité des documents d’évaluation décentralisée par rapport aux normes du CAD de l’OCDE et d’AMC; ii) les aspects des évaluations qui dépassent ces normes ou qui n’y répondent pas; iii) les forces et les faiblesses du processus de planification des évaluations décentralisées; iv) l’utilité des rapports d’évaluation décentralisée; v) la mise en application ou non des recommandations de la méta-évaluation de 2008, et vi) les possibilités d’améliorer les SIG actuels d’AMC.

Les six questions sont divisées en 20 sous-questions, lesquelles ont servi à structurer le chapitre 5 portant sur les constatations. Une grille d’évaluation détaillée a ensuite été élaborée pour présenter la façon dont l’étude permettra de répondre à chacune de ces sous-questions.

4.2 Méthodes

La portée de cette étude a permis à l’équipe d’Itad d’examiner en détail la qualité de l’évaluation destinée à AMC. Alors que les méta-évaluations passées ne se sont concentrées que sur certains aspects des déterminants de la qualité, la présente étude s’est penchée sur la qualité des documents d’évaluation, ainsi que sur les processus, le cadre institutionnel, les capacités et les systèmes de soutien qui tous jouent un rôle dans la détermination de la qualité. Pour ce faire, la méta-évaluation comporte six volets : i) un examen de la qualité des documents; ii) un sondage en ligne auprès du personnel; iii) un examen des processus de PCE/USE; iv) un ensemble d’études de cas approfondies; v) un examen des SIG d’AMC en vue des évaluations, et vi) un examen de la méta-évaluation de 2008. Le lien entre ces éléments et les processus d’évaluation décentralisée d’AMC est illustré à la Figure 1. Le plan de travail de l’étude, approuvé par PCE, décrit la méthodologie en détail.Note de bas de page 16

Figure 1 : Processus d’évaluation et volets de l’étude

4.2.1 Examen de la qualité des documents

L’examen de la qualité porte sur le cadre de référence, les plans de travail, les rapports d’évaluation préliminaire et final ainsi que les réponses de la direction. Les gabarits se fondent sur les outils de PCE et les normes du CAD de l’OCDE. Chacun des 72 critères de qualité précis et les 16 niveaux de qualité générale ont été évalués sur une échelle de 1 à 4. Bien qu’un échantillon de 125 évaluations ait été choisi au départ,Note de bas de page 17 l’échantillon utilisé n’en compte que 116.Note de bas de page 18 Une analyse quantitative et qualitative des données d’examen a été effectuée afin de déterminer le caractère représentatif de l’échantillon, les caractéristiques des documents d’évaluation, les profils de variation de la qualité par rapport à un ensemble de variables indépendantes et les associations relatives à la qualité à faire entre les quatre livrables.

4.2.2 Sondage en ligne

Un sondage Web mené auprès du personnel d’AMC a permis de connaître les perceptions quant à la planification et l’utilisation des évaluations décentralisées, ainsi qu’à l’utilité du soutien de l’USE. Il nous a aidés à cerner les questions de suivi à poser lors des études de cas approfondies et des entrevues avec la haute direction. Quelque 114 membres du personnel ont répondu au sondage, et des résultats utilisables ont été obtenus de 90 d’entre eux.

4.2.3 Études de cas approfondies

Les études de cas ont permis d’explorer les obstacles et les catalyseurs d’une bonne planification de l’évaluation et de connaître les raisons et les façons d’utiliser les évaluations décentralisées. Un échantillon de 10 évaluations a été choisi à dessein pour tenir compte des divers niveaux de qualité et d’utilisation dans l’ensemble des six secteurs. Seulement huit ont pu être évaluées en raison des difficultés à joindre le personnel concerné, et une entrevue a été menée auprès de 25 personnes.

4.2.4 Examen des processus de PCE pour soutenir les évaluations décentralisées

Nous nous sommes concentrés sur le travail de l’USE, qui offre à la fois de l’assurance de la qualité tout au long du processus d’évaluation et des conseils techniques sur les concepts et méthodes d’évaluation au personnel d’AMC. L’étude a porté sur les capacités du personnel de l’USE, ainsi que sur les outils et processus qu’il utilise dans le cadre de son travail. Des données probantes ont été tirées de plusieurs sources : l’examen de la qualité, les entrevues auprès de 23 employés et consultants, les études de cas approfondies et les autres entrevues menées auprès de la haute direction et de consultants expérimentés d’AMC.

4.2.5 Examen des SIG d’AMC en vue des évaluations

Il s’agit ici d’examiner les systèmes en place à AMC pour stocker et partager les connaissances d’évaluation, puis de les comparer à ceux de quatre autres agences afin de cerner les pratiques exemplaires.Note de bas de page 19

4.2.6 Examen de la méta-évaluation de 2008

Les recommandations de la méta-évaluation menée en 2008 ont été examinées à la lumière des données probantes découlant des autres volets de l’étude. Nous avons ainsi pu évaluer l’ampleur des changements survenus au cours de la période d’examen, de même que déterminé si les recommandations de l’étude de 2008 avaient fait l’objet d’un suivi.

4.3 Limites

L’évaluabilité et la conception de la méta-évaluation en vue de la présente étude ont soulevé un certain nombre de limites.

Cette étude était nécessaire pour définir la qualité des évaluations décentralisées en fonction de leur conformité à des normes internationales reconnues, soit celles proposées par le CAD de l’OCDE. Bien que ces normes soient détaillées et acceptées par le monde entier, il est possible d’utiliser d’autres façons d’évaluer la qualité qui reposent sur le point de vue des intervenants. En effet, le document d’orientation indique que les normes du CAD ne devraient pas exclure l’utilisation d’autres normes ni supplanter les directives propres à certains types d’évaluations.

Dans toute évaluation des facteurs touchant la qualité et l’utilisation des évaluations, certains aspects seront toujours difficiles à évaluer lorsque le travail est mené à distance ou à partir de documents secondaires. Parmi ces aspects, il y a la relation parfois imprévisible qui existe entre les gestionnaires de l’évaluation, les évaluateurs et les personnes évaluées, ainsi que les situations de conflits ou de biais entre les acteurs qui ne sont pas nécessairement rapportées dans les documents. Ces aspects ont été difficiles à évaluer dans l’examen de la qualité, mais l’équipe d’étude a réussi à découvrir de l’information sur ces questions délicates dans les études de cas, et cette information lui a été très utile pour se faire une meilleure idée des défis à surmonter au moment de mener une évaluation décentralisée.

En raison de l’absence à AMC d’un système pour faire le suivi de la mise en œuvre des réponses de la direction, ainsi que du nombre restreint et du format des rapports sur cette question, il existe très peu de moyens d’estimer l’utilisation. De plus, même si l’évaluation de l’outil qu’est la réponse de la direction faisait partie des volets clés de l’étude pour évaluer l’utilisation des évaluations, elle n’a pas permis de rendre compte de tous les résultats formels et informels des évaluations. À elle seule, elle ne constitue donc pas une mesure complète de l’utilité des évaluations décentralisées (consulter la section 5.4 pour plus de détails). Des entrevues clés ont cependant permis, dans une certaine mesure, de compenser cette lacune.

L’étude n’a pas permis d’explorer en détail les normes « générales » du CAD de l’OCDE sur la transparence, le partenariat, la coordination ou le renforcement des capacités, puisque ces critères n’ont pas été retenus pour l’examen de la qualité.

Nous avons eu quelques problèmes pratiques pour accéder aux documents et aux intervenants dans le cadre de l’examen de la qualité et des études de cas. La tâche de trouver tous les rapports pertinents s’est révélée ardue, et lorsque les documents sont demeurés introuvables, il a fallu obtenir des documents de remplacement, avec l’aide de PCE. Le plus petit échantillon de cadres de référence, de plans de travail et de réponses de la direction a restreint la portée de notre étude. Dans certains cas, les employés d’AMC concernés ont été réaffectés ou ont pris leur retraite, et il n’a pas toujours été possible de trouver les meilleures personnes à interroger. De nombreuses évaluations ont été menées il y a cinq ans, et les personnes interrogées ont peiné à s’en souvenir. Néanmoins, pour la plupart des études de cas et des entrevues avec la direction, le personnel approprié a pu être joint et se souvenait de détails pertinents.

L’échantillon de 114 répondants au sondage en ligne était acceptable, ce qui représente environ 20 % de l’ensemble statistique potentiel de plus de 500 employés invités à participer.Note de bas de page 20 Le profil des répondants correspond bien aux secteurs et aux catégories d’employés. En ce qui concerne l’examen de la qualité, l’échantillon de 116 documents a suffi pour effectuer une analyse comparative de base, mais le recours à des outils de corrélation plus perfectionné a été limité par la taille de l’échantillon. Comme l’indiquent les constatations de l’étude, les résultats de ce travail doivent être pris avec circonspection.

5 Constatations

Le présent chapitre rend compte des principales constatations de la méta-évaluation à partir de chacune des questions et sous-questions d’évaluation mentionnées à la section 4.1.

5.1 Qualité des évaluations décentralisées

5.1.1 Représentativité de l’échantillon utilisé pour l’examen de la qualité

L’échantillon de 116 rapports d’évaluation examinés pour leur qualité était également réparti entre les secteurs, selon la proportion des évaluations inventoriées. Les secteurs les mieux représentés sont l’Asie, l’Afrique et les Amériques, avec quelques rapports venant des secteurs Enjeux mondiaux et développement (MFM), Partenariats pour l’innovation dans le développement (KFM) et Europe, Moyen-Orient et Maghreb (EGM). La plupart des évaluations étaient formatives (46 %, y compris les évaluations à mi-mandat) ou sommatives (41 %, y compris les évaluations de projet finales), ce qui correspond bien à la proportion de ces types d’évaluation dans l’inventaire. Le budget moyen des projets de l’échantillon, soit 20 millions de dollars, était légèrement supérieur au budget moyen de 15 millions de dollars dans l’inventaire.Note de bas de page 21 Tous les thèmes prioritaires d’AMC et secteurs du CAD de l’OCDE étaient couverts par l’échantillon. Les domaines les mieux représentés avaient trait à la gouvernance démocratique et au développement économique. Le budget moyen des évaluations était de 103 000 $ (lorsque cette donnée était mentionnée). Les répartitions par secteur, thème et budget d’évaluation ne peuvent malheureusement être comparées à l’inventaire général puisque ces données n’y figurent pas. Cependant, selon des discussions tenues avec AMC, la couverture par thème et secteur, ainsi que le niveau des coûts d’évaluation, semblerait représentative.Note de bas de page 22

5.1.2 Quelle est la qualité des documents d’évaluation décentralisée par rapport aux normes du CAD de l’OCDE?

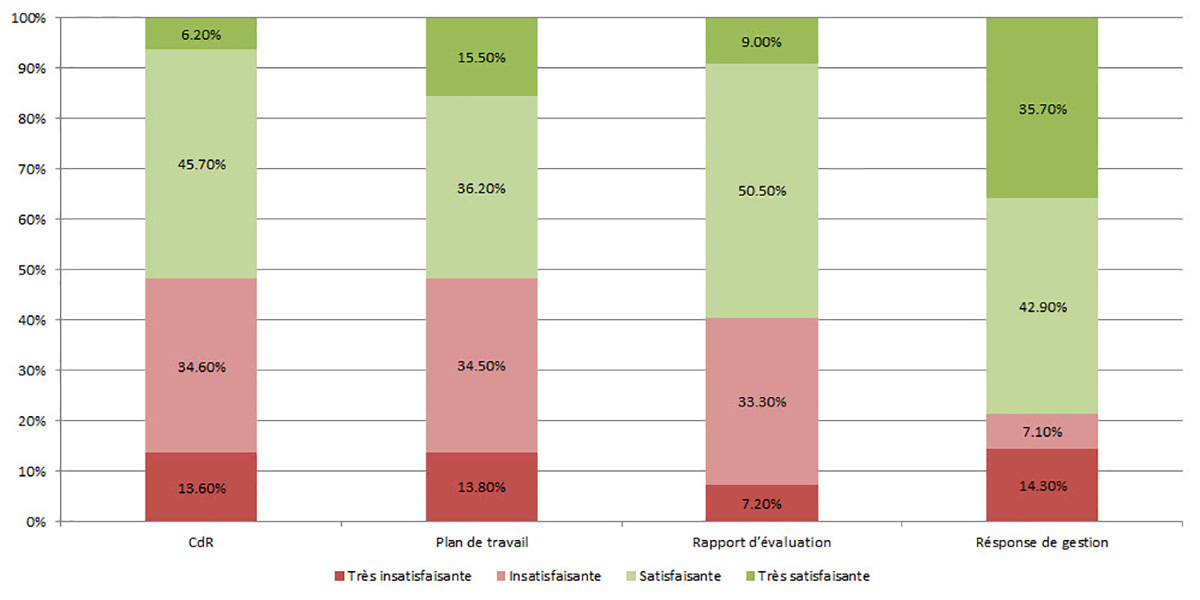

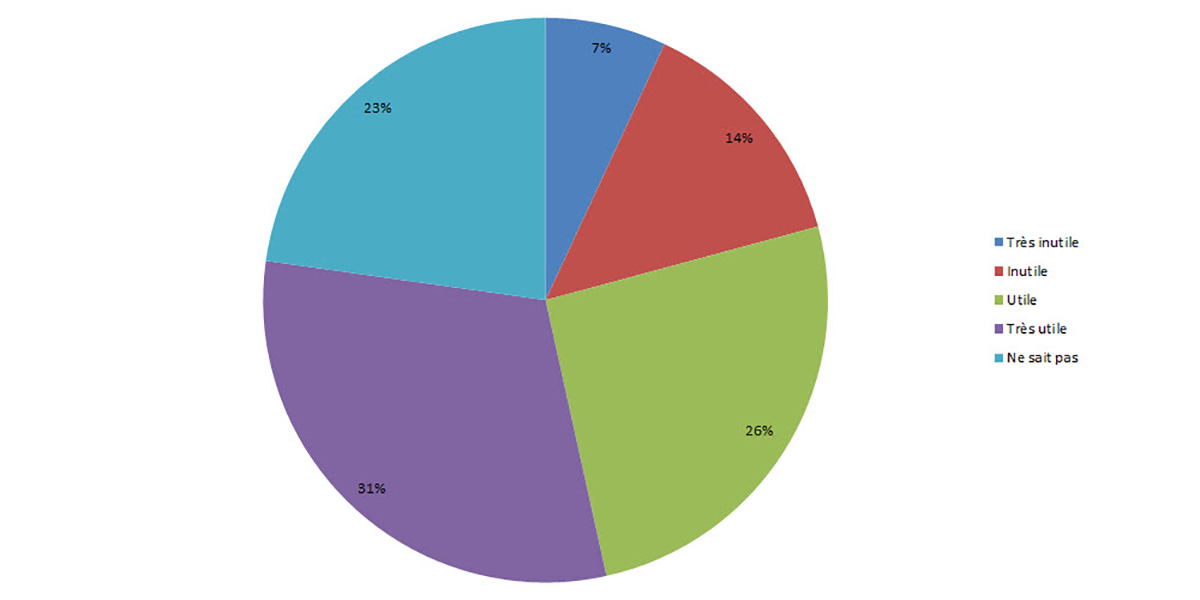

Pour répondre à cette question, l’étude s’est penchée sur la seule note accordée à la qualité générale de chaque document d’évaluation (Figure 2). L’examen a permis de constater que 59 % des 116 rapports d’évaluation respectaient les normes du CAD de l’OCDE et de PCE (selon une note de qualité générale de 3 ou 4), et que c’était aussi le cas de 52 % des 81 cadres de référence et 52 % des 58 plans de travail. Des 28 réponses de la direction, 79 % étaient également d’un niveau de qualité satisfaisante, mais les critères de qualité utilisés étaient beaucoup moins difficiles à évaluer (liés à des questions comme le degré d’engagement à faire le suivi des recommandations), alors que la taille de l’échantillon de ce type de document était plus petite, donc possiblement moins représentative.

Bien que la plupart des documents aient été jugés de qualité satisfaisante, il convient de noter que seul un petit pourcentage d’entre eux semble très satisfaisant, de sorte que la majorité des documents de ce groupe présentent toujours à certains égards des lacunes qui pourraient limiter leur fiabilité ou leur utilité. Les forces et les faiblesses de chaque document sont examinées dans les sections suivantes.

Figure 2 : Répartition des notes obtenues pour la qualité de l’ensemble des évaluations

Vesion texte

| L’ensemble des évaluations | Très insatisfaisante | Insatisfaisante | Satisfaisante | Très satisfaisante |

|---|---|---|---|---|

| CdR | 13,6 % | 34,6 % | 45,7 % | 6,2 % |

| Plan de travail | 13,8 % | 34,5 % | 36,2 % | 15,5 % |

| Rapport d’évaluation | 7,2 % | 33,3 % | 50,5 % | 9,0 % |

| Résponse de gestion | 14,3 % | 7,1 % | 42,9 % | 35,7 % |

Facteurs expliquant la qualité globale des évaluations

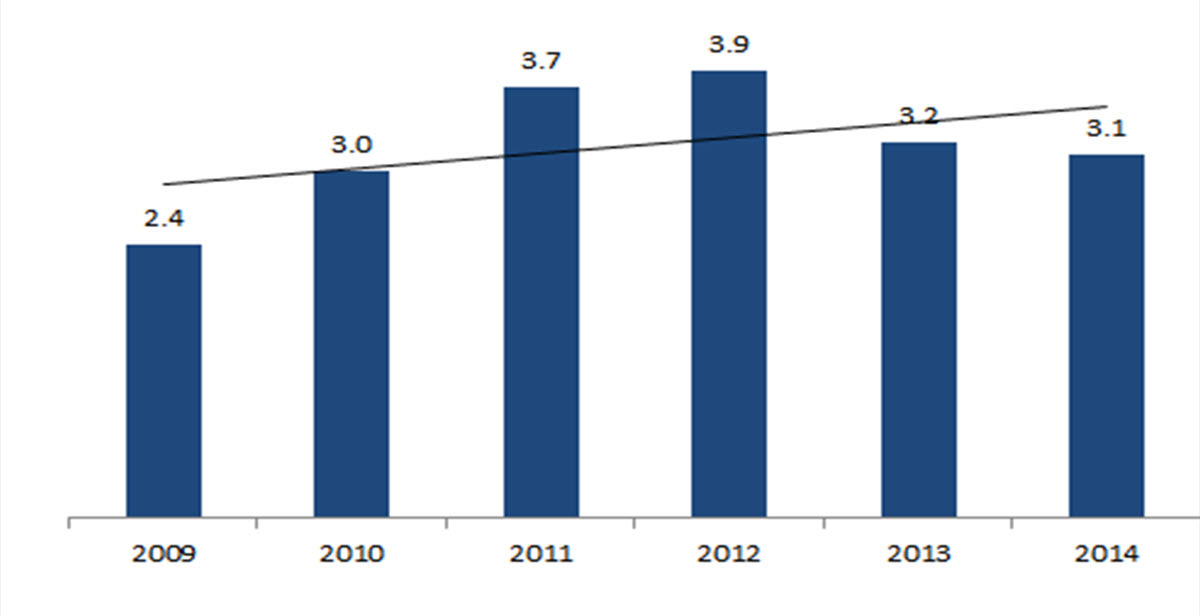

La proportion des rapports d’évaluation présentant un niveau de qualité générale satisfaisant varie d’année en année, mais il semble que leur qualité ait connu un sommet en 2012 (Figure 3); toutefois, les données n’ont pas permis d’en avoir le cœur net dans le cadre de l’examen. Ainsi, en 2013 et 2014, 71 % (des 21 rapports) et 100 % (des 7 rapports) ont obtenu une note satisfaisante. Dans l’ensemble, une simple droite de tendance superposée au graphique indique une modeste amélioration de la qualité au cours de la période.Note de bas de page 23

Figure 3 : Note moyenne de la qualité des rapports d’évaluation au cours de 2006-2014Note de bas de page 24

Les notes varient de 1 à 4, avec un niveau de qualité moyen de 2,5.

Vesion texte

| 2009 | 2010 | 2011 | 2012 | 2013 | 2014 |

|---|---|---|---|---|---|

| 2,4 | 3,0 | 3,7 | 3,9 | 3,2 | 3,1 |

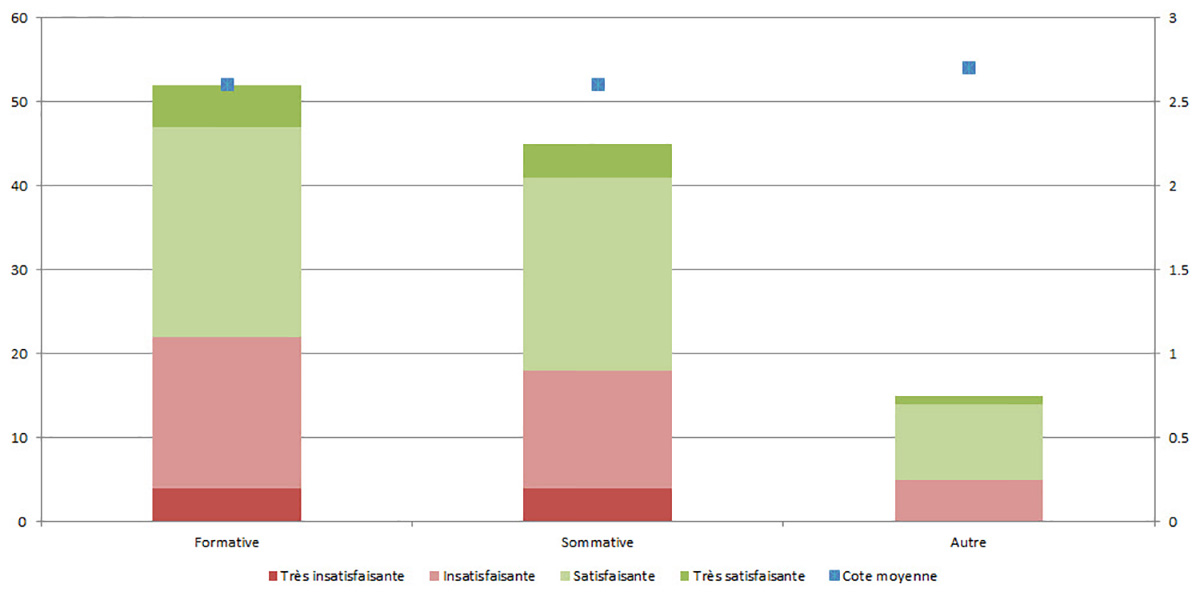

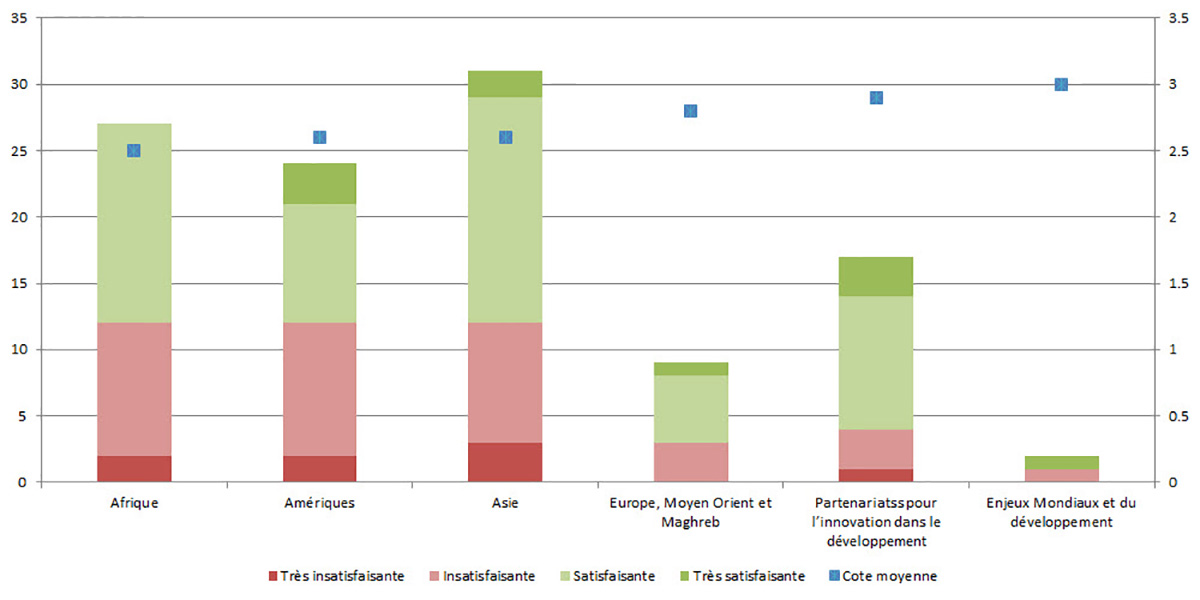

On ne constate aucune différence significative entre la qualité des rapports d’évaluation selon le type ou le secteur (Figure 4 et Figure 5), bien que les évaluations commandées par les secteurs du partenariat et du multilatéral semblent légèrement de meilleure qualité que celles commandées par les trois secteurs régionaux.

Figure 4 : Répartition des notes obtenues pour la qualité des rapports d’évaluation selon le type d’évaluationNote de bas de page 25

Vesion texte

| Le type d’évaluation | Très insatisfaisante | Insatisfaisante | Satisfaisante | Très satisfaisante | Cote moyenne |

|---|---|---|---|---|---|

| Formative | 4 | 18 | 25 | 5 | 2,6 |

| Sommative | 4 | 14 | 23 | 4 | 2,6 |

| Autre | 0 | 5 | 9 | 1 | 2,7 |

Figure 5 : Répartition des notes obtenues pour la qualité des rapports d’évaluation selon le secteur

Vesion texte

| Secteur | Très insatisfaisante | Insatisfaisante | Satisfaisante | Très satisfaisante | Cote moyenne |

|---|---|---|---|---|---|

| Afrique | 2 | 10 | 15 | 0 | 24 |

| Amériques | 2 | 10 | 9 | 3 | 25 |

| Asie | 3 | 9 | 17 | 2 | 25 |

| Europe, Moyen Orient et Maghreb | 0 | 3 | 5 | 1 | 28 |

| Partenariatss pour l’innovation dans le développement | 1 | 3 | 10 | 3 | 29 |

| Enjeux Mondiaux et du développement | 0 | 1 | 0 | 1 | 30 |

On constate une forte relation positive entre le coût élevé d’un projet et la meilleure qualité de l’évaluation (Tableau 2).

| Note de qualité générale | Budget moyen des projets $ | Nombre de rapports |

|---|---|---|

| Très insatisfaisant | 8 857 543 | 8 |

| Insatisfaisant | 14 968 602 | 35 |

| Satisfaisant | 21 205 345 | 53 |

| Très satisfaisant | 46 001 917 | 8 |

| Total | 20 064 039 | 104 |

On constate également une relation modérée mais tout de même significative entre le coût budgeté d’un projet et le budget d’évaluation attribué à ce projet.Note de bas de page 26

On ne distingue aucune association claire entre la qualité du rapport et la taille de l’équipe d’évaluation dans les 86 cas pour lesquels des données étaient disponibles. Il y avait toutefois un lien entre le fait que le chef d’équipe était aussi un spécialiste de l’évaluation et la qualité du plan de travail et du rapport d’évaluation. Les trois quarts des plans de travail et des rapports d’évaluation étaient satisfaisants lorsque le chef d’équipe faisait partie des évaluateurs, alors que seuls le quart des plans de travail et la moitié des rapports d’évaluation étaient satisfaisants lorsque le chef d’équipe ne jouait pas le rôle d’évaluateur.

Quant aux 31 cas pour lesquels on dispose de renseignements, la taille du budget d’évaluation ne présente pas de lien évident avec la qualité ni du plan de travail ni du rapport d’évaluation.

5.2 Aspects de la qualité des documents d’évaluation d’AMC qui dépassent les normes du CAD ou qui n’y répondent pas

L’équipe d’étude a d’abord colligé les données probantes obtenues par divers outils lors de la méta-évaluation, puis déterminé si chacune des normes de qualité du CAD de l’OCDE était respectée. Elle a ainsi obtenu une évaluation partielle en raison du manque de données probantes pour certains aspects.

En ce qui a trait aux normes du CAD portant sur les considérations générales en matière d’évaluation, les données probantes ne suffisent pas pour commenter quatre des critères, puisque l’examen de la qualité et les études de cas n’ont pas permis d’explorer les questions de transparence, de partenariat, de coordination ou de renforcement des capacités de façon assez poussée. Cela dit, les indications trouvées dans les documents pour déterminer dans quelle mesure les évaluations ont été menées conformément aux principes éthiques pertinents (comme la confidentialité, la protection de la vie privée, le consentement éclairé et le respect des droits de la personne) étaient satisfaisantes dans très peu de documents d’évaluation (seulement 6 % des évaluations).Note de bas de page 27 Le respect des normes de contrôle de la qualité fluctue : c’est le cas de 61 % des cadres de référence, mais de seulement 48 % des plans de travail.

Quant aux normes du CAD relatives à la planification des évaluations, la situation est relativement bonne : 7 des 12 normes de qualité ont été respectées dans la majorité des documents. Les exceptions sont l’évaluabilité, ainsi que le choix d’une approche et d’une méthodologie, pour lesquelles la norme de qualité a été respectée dans environ le tiers des cas seulement.

Dans le cas des normes du CAD concernant la mise en œuvre et la présentation des résultats, 9 des 15 normes ont été satisfaites. Les aspects de la qualité qui respectent davantage les normes concernent la clarté du rapport, la logique de l’intervention et la consultation des parties prenantes. Les documents font moins bonne figure pour ce qui est de la méthodologie et des limites.

Enfin, la situation est la moins reluisante en ce qui concerne les normes de qualité liées à l’utilisation des évaluations. Les réponses de la direction respectent généralement la norme de qualité qui lui est appliquée, mais lorsqu’on tient compte des opinions exprimées lors des entrevues et dans le sondage en ligne, la norme relative à l’utilité est considérée comme partiellement respectée, alors que les normes liées à la réponse et au suivi des recommandations et à la diffusion ne sont pas satisfaites.

La section qui suit examine la qualité des quatre documents d’évaluation en fonction des divers critères du CAD de l’OCDE.

5.2.1 Cadres de référence

La qualité est à la fois satisfaisante et insatisfaisante (52 % et 49 %) dans les 81 cadres de référence évaluées; seulement 6 % ont été jugés très satisfaisants. L’analyse des résultats au fil du temps laisse entrevoir une amélioration de la qualité des cadres de référence depuis 2009, ainsi qu’une baisse générale de la proportion des cadres de référence jugés globalement comme non conformes aux normes du CAD de l’OCDE.

Selon les quatre principales sections du gabarit utilisé, on constate que les cadres de référence sont généralement de meilleure qualité à la section 3, sur la gestion et les processus, et à la section 2, sur la finalité, les objectifs et la portée. Plus de 80 % des cadres de référence sont jugés satisfaisants pour la qualité des aspects suivants : justification et finalité de l’évaluation, définir des objectifs spécifiques et définir clairement les livrables.

Les cadres de référence sont de moindre qualité pour les aspects couverts à la section 1, portant sur la structure (présentation et annexes), et à la section 4, portant sur les facteurs généraux (égalité des sexes, éthiques, limites). Les aspects les plus faibles sont ceux liés à l’éthique (qui, soit dit en passant, ne font pas partie des directives de l’USE), à la définition des limites attendues de l’évaluation, aux constatations et recommandations des évaluations précédentes et à la description du contexte.

5.2.2 Plans de travail

L’étude s’est penchée sur 58 plans de travail, et la qualité a été jugée satisfaisante dans 52 % des cas et insatisfaisante dans 49 % des cas. Les plans de travail sont le plus souvent satisfaisants lorsqu’il s’agit de décrire la finalité et les objectifs de l’évaluation à mener, ainsi que de décrire les mesures de gestion adéquates en vue du processus d’évaluation. L’aspect le plus faible concerne la définition des méthodes et outils appropriés : seulement 44 % des plans de travail respectent les normes du CAD de l’OCDE à ce chapitre.

Les données longitudinales donnent à penser que les plans de travail se sont grandement améliorés en 2013 et 2014, après une période de moindre qualité en 2012 et antérieurement. Voilà qui a sans doute marqué le début d’une tendance positive, bien que les cas soient relativement peu nombreux pour le confirmer.

Quant aux critères individuels, l’évaluation des plans de travail a révélé un certain nombre de forces. Plus de 70 % des plans ont été jugés satisfaisants pour les critères suivants : bonne définition des objectifs de l’évaluation, définition d’une portée appropriée, présence d’un niveau de participation des parties prenantes adéquat et description d’une équipe et d’un processus de gestion adéquats. Les critères de qualité non satisfaits sont une description inadéquate du contexte de l’évaluation, des méthodes d’analyse des données mal définies et le non-respect des normes en matière d’éthique et d’égalité des sexes. La qualité semble également plus faible lorsqu’il s’agit d’assurer des processus d’assurance de la qualité et de préciser les méthodes d’échantillonnage des données appropriées.

5.2.3 Rapports d’évaluation

La qualité générale des 116 rapports d’évaluation évalués est légèrement supérieure à celle des cadres de référence et des plans de travail : 50 % sont jugés satisfaisants et 9 %, très satisfaisants. Ce constat peut s’expliquer par la plus grande attention, ainsi que le niveau d’effort et le temps accordés à la rédaction du rapport d’évaluation final par rapport aux cadres de référence et aux plans de travail.

Selon les quatre principales sections du modèle d’examen, les aspects de la qualité qui s’en tirent mieux sont l’analyse logique et pertinente qui mène à des constatations, conclusions, recommandations et leçons apprises appropriées. Les aspects de la qualité qui laissent plus à désirer concernent l’absence de méthodes détaillées et appropriées; seulement 39 % des rapports respectent la norme requise à ce chapitre. Cette moindre qualité a des répercussions sur la qualité des données probantes qui ont été utilisées aux étapes subséquentes du processus d’évaluation en vue de formuler des constatations solides.

L’analyse des données longitudinale a débouché sur des observations similaires à celles faites sur les plans de travail, soit une amélioration de la qualité en 2013 et 2014 après un creux en 2012.

Quant aux critères individuels, l’évaluation des rapports d’évaluation a permis de constater que plus de 70 % d’entre eux sont satisfaisants pour ce qui est de définir des objectifs spécifiques, de décrire l’objet de l’évaluation, d’évaluer la qualité du système de suivi et d’évaluation et de formuler des constatations solides et détaillées. La qualité est moins bonne en ce qui concerne l’intégration des normes d’égalité des sexes et d’éthique, la prise en compte des évaluabilités ou la présentation des données des évaluations précédentes, et lorsque la description des méthodes est mauvaise (ou que les méthodes précisées sont peu pertinentes ou présentent d’importantes limites).

5.2.4 Réponses de la direction

Vu la disponibilité des documents, un échantillon relativement petit de 28 réponses de la direction a fait l’objet d’une évaluation de la qualité. Dans l’ensemble, lorsqu’elles sont disponibles, les réponses de la direction sont jugées solides, 79 % respectant la norme de qualité souhaitée. Cela dit, le format du rapport ne s’est pas avéré efficace pour juger de l’application des critères du CAD de l’OCDE.Note de bas de page 28

Certaines parties de la réponse de la direction sont de qualité supérieure, surtout lorsqu’il s’agit de donner une réponse immédiate aux recommandations (et de les accepter, de les refuser ou de les adapter). La qualité est toutefois relativement moindre, quoique tout de même bonne, pour ce qui est des engagements envers la prise de mesures concrètes, de l’identification des personnes responsables et de l’établissement de dates limites.

5.2.5 Associations entre les documents d’évaluation et les caractéristiques de qualité